प्रमुख घटक विश्लेषण

प्रमुख कंपोनेंट विश्लेषण (पीसीए) प्रति अवलोकन उच्च संख्या में आयाम/फीवेरिएबल वाले बड़े डेटासमुच्चय का विश्लेषण करने, अधिकतम मात्रा में जानकारी को संरक्षित करते हुए डेटा की व्याख्या को बढ़ाते हैं, और बहुआयामी डेटा के विज़ुअलाइज़ेशन को सक्षम करने के लिए लोकप्रिय तकनीक है औपचारिक रूप से, पीसीए डेटासमुच्चय के आयाम को कम करने के लिए सांख्यिकीय तकनीक है। यह डेटा को रैखिक रूप से नई समन्वय प्रणाली में परिवर्तित करके पूरा किया जाता है, जहां (अधिकांश) डेटा में भिन्नता को प्रारंभिक डेटा की तुलना में कम आयामों के साथ वर्णित किया जा सकता है। डेटा को दो आयामों में प्लॉट करने के लिए और निकट से संबंधित डेटा बिंदुओं के समूहों की दृष्टि से पहचान करने के लिए अनेक अध्ययन पहले दो प्रमुख अवयवों का उपयोग करते हैं। प्रमुख कंपोनेंट विश्लेषण के अनेक क्षेत्रों में जैसे जनसंख्या आनुवंशिकी, माइक्रोबायोम अध्ययन और वायुमंडलीय विज्ञान में अनुप्रयोग होते हैं ।[1]

वास्तविक समन्वय स्थान में बिंदुओं के संग्रह के प्रमुख अवयव यूनिट सदिश अनुक्रम हैं, जहां -वें सदिश रेखा की दिशा है जो पहले सदिश के लिए ऑर्थोगोनल होते हुए डेटा को सबसे अच्छी तरह से फिट करता है। यहां, सर्वोत्तम-फिटिंग लाइन को उस रेखा के रूप में परिभाषित किया गया है जो बिंदु से रेखा तक औसत वर्ग लंबवत दूरी दूरी को कम करता है। ये दिशाएँ अलौकिक आधार का गठन करती हैं जिसमें डेटा के विभिन्न व्यक्तिगत आयाम रैखिक सहसंबंध होते हैं। प्रमुख अवयव विश्लेषण प्रमुख अवयवों की गणना करने और डेटा के आधार पर परिवर्तन करने के लिए उनका उपयोग करने की प्रक्रिया है, कभी-कभी केवल पहले कुछ प्रमुख अवयवों का उपयोग करके और बाकी की अनदेखी करते हुए उपयोग किया जाता है।

डेटा विश्लेषण में, वेरिएबल समुच्चय का पहला प्रमुख अवयव , जिसे संयुक्त रूप से सामान्यतः वितरित माना जाता है, मूल वेरिएबल के रैखिक संयोजन के रूप में गठित व्युत्पन्न वेरिएबल है जो सबसे अधिक विचरण की व्याख्या करता है। दूसरा प्रमुख अवयव पहले अवयव के प्रभाव को हटा दिए जाने के पश्चात जो बचा है उसमें सबसे अधिक भिन्नता की व्याख्या करता है, और हम पुनरावृत्तियाँ इसके माध्यम से आगे बढ़ सकते हैं जब तक कि सभी विचरण की व्याख्या नहीं की जाती। पीसीए का सबसे अधिक उपयोग तब किया जाता है जब अनेक वेरिएबल दूसरे के साथ अत्यधिक सहसंबद्ध होते हैं और उनकी संख्या को स्वतंत्र समुच्चय में कम करना वांछनीय होता है।

पीसीए का उपयोग खोजपूर्ण डेटा विश्लेषण और प्रेडिक्टिव मॉडलिंग करने के लिए किया जाता है। यह सामान्यतः प्रत्येक डेटा बिंदु को केवल पहले कुछ प्रमुख अवयवों पर प्रक्षेपित करके आयामीता में कमी के लिए उपयोग किया जाता है जिससे जितना संभव हो उतना डेटा भिन्नता को संरक्षित करते हुए निम्न-आयामी डेटा प्राप्त किया जा सके। पहले प्रमुख अवयव को समान रूप से दिशा के रूप में परिभाषित किया जा सकता है जो अनुमानित डेटा के विचरण को अधिकतम करता है। वें>-वें प्रमुख अवयव को पहले प्रमुख अवयव के लिए दिशा ऑर्थोगोनल के रूप में लिया जा सकता है जो अनुमानित डेटा के विचरण को अधिकतम करते हैं।

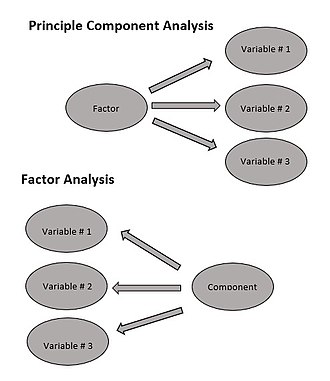

किसी भी उद्देश्य के लिए, यह दिखाया जा सकता है कि प्रमुख अवयव डेटा के सहप्रसरण आव्युह के आइजन्वेक्टर हैं। इस प्रकार, प्रमुख अवयवों की गणना अधिकतर डेटा सहप्रसरण आव्युह के आइजेनडीकम्पोज़िशन या डेटा आव्युह के एकवचन मूल्य अपघटन द्वारा की जाती है। पीसीए सच्चे आइजन्वेक्टर -आधारित बहुभिन्नरूपी विश्लेषणों में सबसे सरल है और कारक विश्लेषण से निकटता से संबंधित है। कारक विश्लेषण में सामान्यतः अंतर्निहित संरचना के बारे में अधिक डोमेन विशिष्ट मान्यताओं को सम्मिलित किया जाता है और थोड़ा भिन्न आव्युह के आइजन्वेक्टर ों को हल करता है। पीसीए भी विहित सहसंबंध | विहित सहसंबंध विश्लेषण (सीसीए) से संबंधित है। सीसीए समन्वय प्रणालियों को परिभाषित करता है जो दो डेटासमुच्चय के बीच क्रॉस सहप्रसरण का बेहतर वर्णन करता है जबकि पीसीए नए ऑर्थोगोनल समन्वय प्रणाली को परिभाषित करता है जो एकल डेटासमुच्चय में भिन्नता का बेहतर वर्णन करता है।[2][3][4][5] मजबूत आंकड़े और एलपी स्पेस | मानक पीसीए के L1-मानक-आधारित संस्करण भी प्रस्तावित किए गए हैं।[6][7][8][5]

इतिहास

पीसीए का आविष्कार 1901 में कार्ल पियर्सन ने किया था।[9] यांत्रिकी में प्रमुख अक्ष प्रमेय के अनुरूप; इसे पश्चात में स्वतंत्र रूप से विकसित किया गया और 1930 के दशक में हेरोल्ड होटलिंग द्वारा इसका नाम दिया गया है।[10] अनुप्रयोग के क्षेत्र के आधार पर, इसे असतत करहुनेन-लोएव प्रमेय भी नाम दिया गया है। संकेत आगे बढ़ाना में करहुनेन-लोएव रूपांतरण (केएलटी), बहुभिन्नरूपी गुणवत्ता नियंत्रण में हेरोल्ड होटलिंग रूपांतरण, मैकेनिकल इंजीनियरिंग में उचित ऑर्थोगोनल अपघटन (पीओडी), एकवचन मूल्य X का अपघटन (एसवीडी) (20वीं शताब्दी की अंतिम तिमाही में आविष्कार किया गया[11]), रेखीय बीजगणित में XTX का आइजेनडीकम्पोज़िशन (ईवीडी)।, कारक विश्लेषण (पीसीए और कारक विश्लेषण के बीच अंतर की चर्चा के लिए जोलिफ़ प्रमुख कंपोनेंट विश्लेषण का अध्याय 7 देखें),[12] एकार्ट-यंग प्रमेय (हरमन, 1960), या अनुभवजन्य ऑर्थोगोनल फ़ंक्शंस (ईओएफ) मौसम विज्ञान में (लॉरेंज, 1956), अनुभवजन्य ईजेनफंक्शन अपघटन (सिरोविच, 1987), क्वासिहार्मोनिक मोड (ब्रूक्स एट अल।, 1988), वर्णक्रमीय प्रमेय ध्वनि और कंपन में वर्णक्रमीय अपघटन, और संरचनात्मक गतिशीलता में अनुभवजन्य मोडल विश्लेषण।

अंतर्ज्ञान

पीसीए को डेटा के लिए p-आयामी दीर्घवृत्त के रूप में फिट करने के बारे में सोचा जा सकता है, जहां दीर्घवृत्त का प्रत्येक अक्ष प्रमुख अवयव का प्रतिनिधित्व करता है। यदि दीर्घवृत्ताभ का कुछ अक्ष छोटा है, तो उस अक्ष के साथ विचरण भी छोटा होता है।

दीर्घवृत्ताभ के अक्षों को खोजने के लिए, हमें सबसे पहले डेटासमुच्चय में प्रत्येक वेरिएबल के मानों को 0 पर केंद्रित करना चाहिए और उनमें से प्रत्येक मान से वेरिएबल के देखे गए मानों का माध्य घटाना चाहिए। प्रत्येक वेरिएबल के लिए मूल देखे गए मानों के अतिरिक्त इन परिवर्तित मानों का उपयोग किया जाता है। फिर, हम डेटा के सहप्रसरण आव्युह की गणना करते हैं और इस सहसंयोजक आव्युह के आइजेनवैल्यू और संबंधित आइजन्वेक्टर की गणना करते हैं। फिर हमें प्रत्येक ऑर्थोगोनल आइजन्वेक्टर को यूनिट सदिश में बदलने के लिए सामान्यीकरण (सांख्यिकी) करना होगा। बार यह हो जाने के पश्चात , प्रत्येक परस्पर-ऑर्थोगोनल यूनिट आइजन्वेक्टर को डेटा में फिट किए गए दीर्घवृत्त के अक्ष के रूप में व्याख्या किया जा सकता है। आधार का यह चुनाव सहप्रसरण आव्युह को विकर्ण रूप में बदल देगा, जिसमें विकर्ण तत्व प्रत्येक अक्ष के विचरण का प्रतिनिधित्व करते हैं। प्रत्येक आइजन्वेक्टर द्वारा दर्शाए गए प्रसरण के अनुपात की गणना उस आइजन्वेक्टर के अनुरूप आइजेनवैल्यू को सभी आइजेनवैल्यू के योग से विभाजित करके की जा सकती है।

पीसीए के निष्कर्षों को समझाने के लिए बिप्लॉटस और स्क्री प्लॉट (व्याख्या विचरण की डिग्री) का उपयोग किया जाता है।

विवरण

पीसीए को ऑर्थोगोनल परिवर्तन रैखिक परिवर्तन के रूप में परिभाषित किया गया है जो डेटा को नई समन्वय प्रणाली में बदल देता है जैसे कि डेटा के कुछ स्केलर प्रक्षेपण द्वारा सबसे बड़ा भिन्नता पहले समन्वय (जिसे पहला मुख्य अवयव कहा जाता है) पर झूठ बोलना आता है, पर दूसरा सबसे बड़ा भिन्नता दूसरा समन्वय, और इसी तरह।[12]

इस पर विचार करें डेटा आव्युह (गणित), X, स्तंभ-वार शून्य अनुभवजन्य माध्य के साथ (प्रत्येक स्तंभ का नमूना माध्य शून्य पर स्थानांतरित कर दिया गया है), जहां प्रत्येक n पंक्तियाँ प्रयोग की भिन्न पुनरावृत्ति का प्रतिनिधित्व करती हैं, और प्रत्येक p कॉलम विशेष प्रकार की सुविधा देता है (कहते हैं, किसी विशेष सेंसर से परिणाम)।

गणितीय रूप से, परिवर्तन को आकार के समुच्चय द्वारा परिभाषित किया जाता है वजन या गुणांक के p-आयामी सदिश वह प्रत्येक पंक्ति सदिश को मानचित्र करता है प्रमुख अवयव स्कोर के नए सदिश के लिए X का , द्वारा दिए गए

इस तरह से कि व्यक्तिगत वेरिएबल डेटा समुच्चय पर विचार किए गए t के क्रमिक रूप से X से अधिकतम संभव विचरण प्राप्त होता है, प्रत्येक गुणांक सदिश w के साथ इकाई सदिश होने के लिए विवश होता है (जहाँ सामान्यतः सख्ती से कम होने के लिए चुना जाता है और आयामीता को कम करने के लिए) चुना जाता है।

पहला घटक

प्रसरण को अधिकतम करने के लिए, पहला भार सदिश w(1) इस प्रकार संतुष्ट करना पड़ता है

समान रूप से इसे आव्युह रूप में लिखने पर प्राप्त होता है

यह समकक्ष भी संतुष्ट करता है जहाँ w(1)के पश्चात से इकाई सदिश के रूप में परिभाषित किया गया है,

अधिकतम की जाने वाली मात्रा को रेले भागफल के रूप में पहचाना जा सकता है। धनात्मक अर्ध निश्चित आव्युह जैसे XTX के लिए मानक परिणाम यह है कि भागफल का अधिकतम संभव मान आव्युह का सबसे बड़ा आइजेनवैल्यू है, जो तब होता है जब w संबंधित आइजन्वेक्टर होता है।

w(1) के साथ मिला, डेटा सदिश x(i) का पहला प्रमुख घटक रूपांतरित निर्देशांक में फिर स्कोर t1(i) = x(i) ⋅ w(1) के रूप में दिया जा सकता है , या मूल वेरिएबल में संबंधित सदिश के रूप में, {x(i) ⋅w(1)} w(1) होता है.

आगे के घटक

k-वें अवयव को 'X' से पहले k − 1 प्रमुख अवयवों को घटाकर प्राप्त किया जा सकता है:

और फिर वेट सदिश का पता लगाना जो इस नए डेटा आव्युह से अधिकतम भिन्नता निकालता है

यह पता चला है कि यह XTX के शेष आइजन्वेक्टर देता है, कोष्ठकों में मात्रा के लिए उनके संबंधित आइजेनवैल्यू द्वारा दिए गए अधिकतम मानों के साथ। इस प्रकार वजन सदिश XTX के आइजन्वेक्टर हैं।

डेटा सदिश x(i) का k-वाँ प्रमुख घटक रूपांतरित निर्देशांक में, इसलिए स्कोर tk(i) = x(i) ⋅ w(k) के रूप में दिया जा सकता है या मूल वेरिएबल के स्थान में संबंधित सदिश के रूप में, {x(i) ⋅ w(k)} w(k), जहां w(k) XTX का kवां आइजन्वेक्टर है।

इसलिए X का पूर्ण प्रमुख अवयव अपघटन इस प्रकार दिया जा सकता है

जहां W वजन का p-द्वारा-p आव्युह है, जिसके कॉलम XTX के आइजन्वेक्टर हैं। डब्ल्यू के स्थानान्तरण को कभी-कभी श्वेत परिवर्तन कहा जाता है। wके कॉलम को इसी आइजेनवैल्यू के वर्गमूल से गुणा किया जाता है, अर्थात , आइजन्वेक्टर को वेरिएंस द्वारा बढ़ाया जाता है, जिन्हें पीसीए या फैक्टर विश्लेषण में 'लोडिंग' कहा जाता है।

सहप्रसरण

XTX को ही डेटासमुच्चय के अनुभवजन्य नमूना सहप्रसरण आव्युह के समानुपाती के रूप में पहचाना जा सकता है XT.[12]: 30–31

डेटासमुच्चय पर दो भिन्न -भिन्न प्रमुख अवयवों के बीच नमूना सहप्रसरण Q द्वारा दिया गया है:

जहाँ w(k) का आइजेनवैल्यू गुण है लाइन 2 से लाइन 3 पर जाने के लिए उपयोग किया गया है। चूँकि आइजन्वेक्टर w(j) और w(k) सममित आव्युह के आइजेनवैल्यू के अनुरूप ओर्थोगोनल हैं (यदि आइजेनवैल्यू भिन्न हैं), या ऑर्थोगोनलाइज़ किया जा सकता है (यदि सदिश समान दोहराया मान साझा करते हैं)। इसलिए अंतिम पंक्ति में गुणनफल शून्य है; डेटासमुच्चय पर विभिन्न प्रमुख अवयवों के बीच कोई नमूना सहप्रसरण नहीं है।

प्रमुख अवयवों के परिवर्तन को चिह्नित करने का और विधि है, इसलिए समन्वय के परिवर्तन के रूप में जो अनुभवजन्य नमूना सहप्रसरण आव्युह को विकर्ण करता है।

आव्युह रूप में, मूल वेरिएबल के लिए अनुभवजन्य सहप्रसरण आव्युह लिखा जा सकता है

प्रमुख अवयवों के बीच अनुभवजन्य सहप्रसरण आव्युह बन जाता है

जहां Λ आइजेनवैल्यू λ(k) का XTX का विकर्ण आव्युह है। λ(k) प्रत्येक अवयव k, अर्थात λ(k) से जुड़े डेटासमुच्चय पर λ(k) = Σi tk2(i) = Σi (x(i) ⋅ w(k))2 वर्गों के योग के समान है

आयाम में कमी

परिवर्तन T = X W डेटा सदिश x(i) को मानचित्र करता है p वेरिएबल्स के मूल स्थान से p वेरिएबल्स के नए स्थान पर जो डेटासमुच्चय पर असंबद्ध हैं। चूँकि , सभी प्रमुख अवयवों को रखने की जरूरत नहीं है। केवल पहले एल आइजेनसदिश ों का उपयोग करके उत्पादित केवल पहले एल प्रमुख अवयवों को बनाए रखना, छोटा परिवर्तन देता है

जहां आव्युह टीL अब n पंक्तियाँ हैं लेकिन केवल L कॉलम हैं। दूसरे शब्दों में, पीसीए रेखीय परिवर्तन सीखता है जहां के कॉलम p × L आव्यूह एल सुविधाओं (प्रतिनिधित्व टी के घटक) के लिए ऑर्थोगोनल आधार बनाते हैं जो अलंकृत हैं।[13] निर्माण द्वारा, केवल एल कॉलम के साथ सभी रूपांतरित डेटा मैट्रिसेस में, यह स्कोर आव्युह मूल डेटा में भिन्नता को अधिकतम करता है जिसे संरक्षित किया गया है, जबकि कुल चुकता पुनर्निर्माण त्रुटि को कम करता है। या .

इस तरह की आयामी कमी उच्च-आयामी डेटासमुच्चय को देखने और संसाधित करने के लिए बहुत ही उपयोगी कदम हो सकता है, जबकि अभी भी डेटासमुच्चय में जितना संभव हो उतना भिन्नता बनाए रखना। उदाहरण के लिए, एल = 2 का चयन करना और केवल पहले दो प्रमुख अवयवों को रखना उच्च-आयामी डेटासमुच्चय के माध्यम से द्वि-आयामी विमान को ढूंढता है जिसमें डेटा सबसे अधिक फैला हुआ है, इसलिए यदि डेटा में क्लस्टर विश्लेषण सम्मिलित है तो ये भी सबसे अधिक फैले हुए हो सकते हैं , और इसलिए द्वि-आयामी आरेख में प्लॉट किए जाने के लिए सबसे अधिक दिखाई देता है; जबकि यदि डेटा के माध्यम से दो दिशाओं (या दो मूल वेरिएबल ) को यादृच्छिक रूप से चुना जाता है, तो क्लस्टर दूसरे से बहुत कम फैल सकते हैं, और वास्तव में दूसरे को काफी हद तक ओवरले करने की संभावना हो सकती है, जिससे वे अप्रभेद्य हो सकते हैं।

इसी तरह, प्रतिगमन विश्लेषण में, व्याख्यात्मक वेरिएबल की संख्या जितनी अधिक होगी, मॉडल को ओवरफिट करने की संभावना उतनी ही अधिक होगी, जो अन्य डेटासमुच्चय के सामान्यीकरण में विफल होने वाले निष्कर्ष का उत्पादन करेगा। दृष्टिकोण, विशेष रूप से जब विभिन्न संभावित व्याख्यात्मक वेरिएबल के बीच मजबूत सहसंबंध होते हैं, तो उन्हें कुछ प्रमुख अवयवों में कम करना और फिर उनके विरुद्ध प्रतिगमन चलाना है, विधि जिसे प्रमुख अवयव प्रतिगमन कहा जाता है।

जब किसी डेटासमुच्चय में वेरिएबल्स ध्वनि गुल वाले हों, तो डायमेंशनलिटी रिडक्शन भी उपयुक्त हो सकता है। यदि डेटासमुच्चय के प्रत्येक कॉलम में स्वतंत्र समान रूप से वितरित गॉसियन ध्वनि होता है, तो 'टी' के कॉलम में समान रूप से वितरित गॉसियन ध्वनि भी सम्मिलित होगा (ऐसा वितरण आव्युह 'डब्ल्यू' के प्रभाव के तहत अपरिवर्तनीय है, जिसे इस रूप में सोचा जा सकता है समन्वय अक्षों का उच्च-आयामी घुमाव)। चूँकि , समान ध्वनि भिन्नता की तुलना में पहले कुछ मुख्य अवयवों में केंद्रित कुल भिन्नता के साथ, ध्वनि का आनुपातिक प्रभाव कम होता है- पहले कुछ अवयव उच्च सिग्नल-टू-ध्वनि अनुपात प्राप्त करते हैं। इस प्रकार पीसीए के पास पहले कुछ प्रमुख अवयवों में सिग्नल को अधिक केंद्रित करने का प्रभाव हो सकता है, जो उपयोगी रूप से आयामीता में कमी द्वारा कब्जा कर लिया जा सकता है; जबकि पश्चात के प्रमुख अवयवों पर ध्वनि हावी हो सकता है, और इसलिए बिना किसी बड़े नुकसान के निपटारा किया जा सकता है। यदि डेटासमुच्चय बहुत बड़ा नहीं है, तो बूटस्ट्रैपिंग (सांख्यिकी)#पैरामेट्रिक बूटस्ट्रैप का उपयोग करके प्रमुख अवयवों के महत्व का परीक्षण किया जा सकता है, यह निर्धारित करने में सहायता के रूप में कि कितने प्रमुख अवयवों को बनाए रखना है।[14]

एकवचन मूल्य अपघटन

प्रमुख अवयवों के परिवर्तन को अन्य आव्युह गुणनखंडन के साथ भी जोड़ा जा सकता है, एक्स का एकवचन मूल्य अपघटन (एसवीडी),

यहाँ Σ n-by-p धनात्मक संख्याओं का विकर्ण आव्युह σ है(k), X के विलक्षण मान कहलाते हैं; U n-by-n आव्युह है, जिसके कॉलम लंबाई n के ऑर्थोगोनल यूनिट सदिश हैं जिन्हें X का बायां एकवचन सदिश कहा जाता है; और W p-by-p आव्युह है जिसके कॉलम लंबाई p के ऑर्थोगोनल यूनिट सदिश हैं और X के सही एकवचन सदिश कहलाते हैं।

इस गुणनखंड के संदर्भ में, आव्युह XTX लिखा जा सकता है

कहाँ एक्स के एकवचन मूल्यों के साथ वर्ग विकर्ण आव्युह है और संतुष्ट करने वाले अतिरिक्त शून्य काट दिया गया है . X के आइजन्वेक्टर गुणनखंडन के साथ तुलनाTX यह स्थापित करता है कि X का सही एकवचन सदिश W, X के आइजन्वेक्टर के समतुल्य हैTX, जबकि एकवचन मान σ(k) का आइजेनवैल्यू λ के वर्गमूल के समान हैं(k) एक्स काटीएक्स।

एकवचन मूल्य अपघटन का उपयोग करके स्कोर आव्युह टी लिखा जा सकता है

इसलिए T का प्रत्येक स्तंभ X के बाएँ एकवचन सदिशों में से द्वारा संबंधित एकवचन मान से गुणा किया जाता है। यह रूप T का ध्रुवीय अपघटन भी है।

आव्युह एक्स बनाने के बिना एक्स के एसवीडी की गणना करने के लिए कुशल एल्गोरिदम मौजूद हैंTX, इसलिए SVD की गणना करना अब डेटा आव्युह से प्रमुख अवयव विश्लेषण की गणना करने का मानक विधि है, जब तक कि केवल कुछ ही अवयवों की आवश्यकता न हो।

आइजन-अपघटन के साथ, छोटा n × L स्कोर आव्युह टीL केवल पहले L सबसे बड़े एकवचन मान और उनके एकवचन सदिशों पर विचार करके प्राप्त किया जा सकता है:

इस तरह से काटे गए एकवचन मूल्य अपघटन का उपयोग करके आव्युह एम या टी का कटाव छोटा सा आव्युह उत्पन्न करता है जो मूल आव्युह के रैंक (रैखिक बीजगणित) एल का निकटतम संभव आव्युह है, के बीच के अंतर के अर्थ में दो में सबसे छोटा संभव फ्रोबेनियस मानदंड है, परिणाम जिसे एकार्ट-यंग प्रमेय [1936] के रूप में जाना जाता है।

आगे के विचार

एकवचन मान (Σ में) आव्युह X के आइजेनवैल्यू के वर्गमूल हैंटीएक्स। प्रत्येक आइजेनवैल्यू विचरण के हिस्से के लिए आनुपातिक है (उनके बहुआयामी माध्य से बिंदुओं की चुकता दूरी के योग का अधिक सही ढंग से) जो प्रत्येक eigenvector के साथ जुड़ा हुआ है। सभी आइजेनवैल्यू का योग उनके बहुआयामी माध्य से बिंदुओं की वर्ग दूरी के योग के समान है। पीसीए अनिवार्य रूप से प्रमुख अवयवों के साथ संरेखित करने के लिए उनके माध्य के चारों ओर बिंदुओं के समुच्चय को घुमाता है। यह पहले कुछ आयामों में जितना संभव हो उतना भिन्नता (ऑर्थोगोनल परिवर्तन का उपयोग करके) ले जाता है। इसलिए, शेष आयामों में मान छोटे होते हैं और सूचना के न्यूनतम नुकसान के साथ गिराए जा सकते हैं (सिद्धांत अवयव विश्लेषण # पीसीए और सूचना सिद्धांत देखें)। पीसीए का उपयोग अधिकतर इस तरह से आयाम में कमी के लिए किया जाता है। पीसीए को उप-स्थान रखने के लिए इष्टतम ऑर्थोगोनल परिवर्तन होने का गौरव प्राप्त है जिसमें सबसे बड़ा भिन्नता है (जैसा कि ऊपर परिभाषित किया गया है)। हालाँकि, यह लाभ अधिक कम्प्यूटेशनल आवश्यकताओं की कीमत पर आता है, उदाहरण के लिए, और जब लागू हो, असतत कोसाइन परिवर्तन के लिए, और विशेष रूप से DCT-II के लिए जिसे केवल DCT के रूप में जाना जाता है। पीसीए की तुलना में अरैखिक आयामीता में कमी तकनीक की कम्प्यूटेशनल रूप से अधिक मांग होती है।

पीसीए वेरिएबल के स्केलिंग के प्रति संवेदनशील है। यदि हमारे पास केवल दो वेरिएबल हैं और उनके पास ही नमूना भिन्नता है और पूरी तरह से सहसंबंधित हैं, तो पीसीए 45 डिग्री से घूर्णन करेगा और मुख्य अवयव के संबंध में दो वेरिएबल के लिए वजन (वे घूर्णन के कोसाइन हैं) समान हो। लेकिन अगर हम पहले वेरिएबल के सभी मानों को 100 से गुणा करते हैं, तो पहला प्रमुख अवयव लगभग उसी वेरिएबल के समान होगा, दूसरे वेरिएबल से छोटे से योगदान के साथ, जबकि दूसरा अवयव दूसरे मूल वेरिएबल के साथ लगभग संरेखित होगा। इसका मतलब यह है कि जब भी भिन्न -भिन्न वेरिएबल ों की भिन्न -भिन्न इकाइयाँ (जैसे तापमान और द्रव्यमान) होती हैं, तो पीसीए विश्लेषण का कुछ हद तक मनमाना विधि होता है। (उदाहरण के लिए सेल्सियस के अतिरिक्त फ़ारेनहाइट का उपयोग करने पर भिन्न -भिन्न परिणाम प्राप्त होंगे।) पियर्सन का मूल पेपर ऑन लाइन्स एंड प्लेन ऑफ़ क्लोजेस्ट फ़िट टू सिस्टम्स ऑफ़ पॉइंट्स इन स्पेस - इन स्पेस का तात्पर्य भौतिक यूक्लिडियन स्पेस से है जहाँ ऐसी चिंताएँ उत्पन्न नहीं होती हैं। पीसीए को कम मनमाना बनाने का विधि यह है कि डेटा को मानकीकृत करके, इकाई विचरण के रूप में स्केल किए गए वेरिएबल का उपयोग किया जाए और इसलिए पीसीए के आधार के रूप में ऑटोकोवरिएंस आव्युह के अतिरिक्त ऑटोकोरिलेशन आव्युह का उपयोग किया जाए। हालाँकि, यह सिग्नल स्पेस के सभी आयामों में इकाई विचरण के उतार-चढ़ाव को संकुचित (या विस्तारित) करता है।

शास्त्रीय पीसीए प्रदर्शन करने के लिए मीन घटाव (उर्फ मीन सेंटरिंग) आवश्यक है जिससे यह सुनिश्चित किया जा सके कि पहला प्रमुख अवयव अधिकतम विचरण की दिशा का वर्णन करता है। यदि औसत घटाव नहीं किया जाता है, तो पहला प्रमुख अवयव इसके अतिरिक्त डेटा के माध्य से अधिक या कम हो सकता है। आधार खोजने के लिए शून्य का मतलब आवश्यक है जो डेटा के अनुमान के न्यूनतम औसत वर्ग त्रुटि को कम करता है।[15] सहसंबंध आव्युह पर प्रमुख अवयव विश्लेषण करते समय माध्य-केंद्रित अनावश्यक है, क्योंकि सहसंबंधों की गणना के पश्चात डेटा पहले से ही केंद्रित है। सहसंबंध दो मानक स्कोर (जेड-स्कोर) या सांख्यिकीय क्षणों के क्रॉस-उत्पाद से प्राप्त होते हैं (इसलिए नाम: पियर्सन प्रोडक्ट-मोमेंट सहसंबंध)। इसके अलावा क्रॉम्रे एंड फोस्टर-जॉनसन (1998) का लेख मॉडरेट रिग्रेशन में मीन-सेंटरिंग: मच अडो अबाउट नथिंग पर देखें। चूँकि सहप्रसरण आव्युह # सहसंबंध आव्युह से संबंध (मानक स्कोर # गणना | Z- या मानक-स्कोर) 'X' के सहसंबंध आव्युह पर आधारित पीसीए 'Z' के सहप्रसरण आव्युह पर आधारित पीसीए के लिए समानता (गणित) है। , 'X' का मानकीकृत संस्करण।

पीसीए पैटर्न पहचान में लोकप्रिय प्राथमिक तकनीक है। हालाँकि, यह वर्ग पृथक्करण के लिए अनुकूलित नहीं है।[16] चूँकि , इसका उपयोग मुख्य अवयव स्थान में प्रत्येक वर्ग के लिए द्रव्यमान के केंद्र की गणना करके और दो या दो से अधिक वर्गों के द्रव्यमान के केंद्र के बीच यूक्लिडियन दूरी की रिपोर्ट करके दो या दो से अधिक वर्गों के बीच की दूरी को मापने के लिए किया गया है।[17] रैखिक विभेदक विश्लेषण विकल्प है जो वर्ग पृथक्करण के लिए अनुकूलित है।

प्रतीकों और संक्षेपों की तालिका

| Symbol | Meaning | Dimensions | Indices |

|---|---|---|---|

| data matrix, consisting of the set of all data vectors, one vector per row | | ||

| the number of row vectors in the data set | scalar | ||

| the number of elements in each row vector (dimension) | scalar | ||

| the number of dimensions in the dimensionally reduced subspace, | scalar | ||

| vector of empirical means, one mean for each column j of the data matrix | |||

| vector of empirical standard deviations, one standard deviation for each column j of the data matrix | |||

| vector of all 1's | |||

| deviations from the mean of each column j of the data matrix | | ||

| z-scores, computed using the mean and standard deviation for each row m of the data matrix | | ||

| covariance matrix | | ||

| correlation matrix | | ||

| matrix consisting of the set of all आइजन्वेक्टर of C, one eigenvector per column | | ||

| diagonal matrix consisting of the set of all आइजेनवैल्यू of C along its principal diagonal, and 0 for all other elements ( note used above ) | | ||

| matrix of basis vectors, one vector per column, where each basis vector is one of the आइजन्वेक्टर of C, and where the vectors in W are a sub-set of those in V | | ||

| matrix consisting of n row vectors, where each vector is the projection of the corresponding data vector from matrix X onto the basis vectors contained in the columns of matrix W. | |

पीसीए के गुण और सीमाएं

गुण

पीसीए के कुछ गुणों में सम्मिलित हैं:[12]

- Property 1: किसी भी पूर्णांक q के लिए, 1 ≤ q ≤ p, ओर्थोगोनल रैखिक परिवर्तन पर विचार करें

- कहाँ क्यू-तत्व सदिश है और (q × p) आव्युह है, और चलो के लिए विचरण -सहप्रसरण आव्युह बनें . फिर का निशान , निरूपित , लेने से अधिकतम होता है , कहाँ के पहले क्यू कॉलम के होते हैं का स्थानान्तरण है .

- Property 2: ओर्थोनॉर्मल परिवर्तन पर फिर से विचार करें

- साथ और पहले की तरह परिभाषित। तब लेने से कम किया जाता है कहाँ के अंतिम क्यू कॉलम से मिलकर बनता है .

इस संपत्ति का सांख्यिकीय निहितार्थ यह है कि पिछले कुछ पीसी महत्वपूर्ण पीसी को हटाने के पश्चात केवल असंरचित बचे हुए ओवर नहीं हैं। क्योंकि इन अंतिम पीसी में जितना संभव हो उतना छोटा प्रसरण होता है, इसलिए ये अपने आप में उपयोगी होते हैं। वे के तत्वों के बीच बिना सोचे-समझे निकट-स्थिर रैखिक संबंधों का पता लगाने में मदद कर सकते हैं x, और वे प्रतिगमन विश्लेषण में भी उपयोगी हो सकते हैं, वेरिएबल के सबसमुच्चय का चयन करने में x, और आउटलाइयर डिटेक्शन में।

- Property 3: (का वर्णक्रमीय अपघटन Σ)

इसके उपयोग को देखने से पहले, हम पहले विकर्ण तत्वों को देखते हैं,

फिर, शायद परिणाम का मुख्य सांख्यिकीय निहितार्थ यह है कि न केवल हम सभी तत्वों के संयुक्त भिन्नताओं को विघटित कर सकते हैं x प्रत्येक पीसी के कारण घटते योगदान में, लेकिन हम संपूर्ण सहसंयोजक आव्युह को योगदान में विघटित भी कर सकते हैं प्रत्येक पीसी से। चूँकि सख्ती से कम नहीं हो रहा है, के तत्व के रूप में छोटा हो जाएगा बढ़ता है, जैसे बढ़ने के लिए गैर-बढ़ रहा है , जबकि के तत्व सामान्यीकरण बाधाओं के कारण समान आकार के रहने की प्रवृत्ति रखते हैं: .

सीमाएं

जैसा कि ऊपर उल्लेख किया गया है, पीसीए के परिणाम वेरिएबल के स्केलिंग पर निर्भर करते हैं। प्रत्येक विशेषता को उसके मानक विचलन द्वारा स्केल करके इसे ठीक किया जा सकता है, जिससे इकाई विचरण के साथ आयामहीन सुविधाओं के साथ समाप्त हो जाए।[18] ऊपर वर्णित पीसीए की प्रयोज्यता कुछ निश्चित (मौन) मान्यताओं द्वारा सीमित है[19] इसकी व्युत्पत्ति में बनाया गया। विशेष रूप से, पीसीए सुविधाओं के बीच रैखिक सहसंबंधों को पकड़ सकता है लेकिन जब इस धारणा का उल्लंघन होता है तो विफल हो जाता है (संदर्भ में चित्र 6ए देखें)। कुछ मामलों में, समन्वय परिवर्तन रैखिकता धारणा को पुनर्स्थापित कर सकते हैं और पीसीए को तब लागू किया जा सकता है (कर्नेल प्रमुख अवयव विश्लेषण देखें)।

पीसीए के लिए सहप्रसरण आव्युह के निर्माण से पहले और सीमा औसत हटाने की प्रक्रिया है। खगोल विज्ञान जैसे क्षेत्रों में, सभी संकेत गैर-नकारात्मक होते हैं, और माध्य-हटाने की प्रक्रिया कुछ खगोलीय जोखिमों के माध्य को शून्य होने के लिए बाध्य करेगी, जिसके परिणामस्वरूप अभौतिक नकारात्मक प्रवाह पैदा होता है,[20]और संकेतों की सही परिमाण को पुनर्प्राप्त करने के लिए आगे की मॉडलिंग की जानी चाहिए।[21] वैकल्पिक पद्धति के रूप में, गैर-नकारात्मक आव्युह गुणनखंडन केवल मेट्रिसेस में गैर-नकारात्मक तत्वों पर ध्यान केंद्रित करता है, जो खगोलभौतिकीय प्रेक्षणों के लिए अच्छी तरह से अनुकूल है।[22][23][24]अधिक देखें #गैर-नकारात्मक आव्युह गुणनखंड|पीसीए और गैर-ऋणात्मक आव्युह गुणनखंडन के बीच संबंध।

यदि एल्गोरिथम को लागू करने से पहले डेटा को मानकीकृत नहीं किया गया है तो पीसीए नुकसान में है। पीसीए मूल डेटा को उस डेटा में बदल देता है जो उस डेटा के प्रमुख अवयवों के लिए प्रासंगिक होता है, जिसका अर्थ है कि नए डेटा वेरिएबल की उसी तरह से व्याख्या नहीं की जा सकती है जैसे मूल थे। वे मूल वेरिएबल ों की रैखिक व्याख्याएँ हैं। इसके अलावा, अगर पीसीए ठीक से नहीं किया जाता है, तो सूचना के नुकसान की उच्च संभावना होती है।[25] पीसीए रैखिक मॉडल पर निर्भर करता है। यदि किसी डेटासमुच्चय के अंदर पैटर्न छिपा हुआ है जो कि अरैखिक है, तो पीसीए वास्तव में विश्लेषण को प्रगति की पूर्ण विपरीत दिशा में ले जा सकता है।[26] कैनसस स्टेट यूनिवर्सिटी के शोधकर्ताओं ने पाया कि उनके प्रयोगों में नमूना त्रुटि ने पीसीए परिणामों के पूर्वाग्रह को प्रभावित किया। यदि विषयों या ब्लॉकों की संख्या 30 से कम है, और/या शोधकर्ता पीसी में पहले से परे रुचि रखते हैं, तो पीसीए आयोजित करने से पहले सीरियल सहसंबंध के लिए पहले सही करना बेहतर हो सकता है।[27]कैनसस स्टेट के शोधकर्ताओं ने यह भी पाया कि यदि डेटा की स्वतःसंबंध संरचना को सही ढंग से नियंत्रित नहीं किया जाता है तो पीसीए गंभीर रूप से पक्षपाती हो सकता है।[27]

पीसीए और सूचना सिद्धांत

आयामीता में कमी के परिणामस्वरूप सामान्यतः सूचना का नुकसान होता है। पीसीए-आधारित डायमेंशनलिटी रिडक्शन कुछ सिग्नल और ध्वनि मॉडल के तहत उस सूचना हानि को कम करता है।

इस धारणा के तहत

वह है, वह डेटा सदिश वांछित सूचना-वाहक संकेत का योग है और ध्वनि संकेत कोई दिखा सकता है कि सूचना-सैद्धांतिक दृष्टिकोण से पीसीए आयामीता में कमी के लिए इष्टतम हो सकता है।

विशेष रूप से, लिंस्कर ने दिखाया कि अगर गाऊसी है और पहचान आव्युह के आनुपातिक आव्युह के साथ गॉसियन ध्वनि है, पीसीए आपसी जानकारी को अधिकतम करता है वांछित जानकारी के बीच और आयामीता-कम उत्पादन .[28] यदि ध्वनि अभी भी गाऊसी है और पहचान आव्युह के समानुपाती सहप्रसरण आव्युह है (अर्थात, सदिश के अवयव iid हैं), लेकिन सूचना देने वाला संकेत गैर-गाऊसी है (जो सामान्य परिदृश्य है), पीसीए कम से कम सूचना हानि पर ऊपरी सीमा को कम करता है, जिसे इस रूप में परिभाषित किया गया है[29][30]

ध्वनि होने पर पीसीए की इष्टतमता भी संरक्षित है सूचना देने वाले संकेत की तुलना में iid और कम से कम अधिक गाऊसी (कुल्बैक-लीब्लर विचलन के संदर्भ में) है .[31] सामान्य तौर पर, भले ही उपरोक्त सिग्नल मॉडल धारण करता है, जैसे ही ध्वनि होता है, पीसीए अपनी सूचना-सैद्धांतिक इष्टतमता खो देता है। आश्रित हो जाता है।

सहप्रसरण विधि का उपयोग करके पीसीए की गणना करना

सहप्रसरण विधि का उपयोग करते हुए पीसीए का विस्तृत विवरण निम्नलिखित है (यह भी देखें यहां) सहसंबंध विधि के विपरीत।[32] लक्ष्य आयाम p के दिए गए डेटा समुच्चय X को छोटे आयाम L के वैकल्पिक डेटा समुच्चय Y में बदलना है। समतुल्य रूप से, हम आव्युह Y को खोजने की कोशिश कर रहे हैं, जहां Y करहुनेन-लोएव प्रमेय है | आव्युह एक्स का करहुनेन-लोव ट्रांसफ़ॉर्म (केएलटी):

- डेटा समुच्चय व्यवस्थित करें

मान लीजिए कि आपके पास p वेरिएबल ों के प्रेक्षणों के समुच्चय से युक्त डेटा है, और आप डेटा को कम करना चाहते हैं जिससे प्रत्येक प्रेक्षण को केवल L वेरिएबल , L <p के साथ वर्णित किया जा सके। आगे मान लीजिए कि डेटा को एन डेटा सदिश के समुच्चय के रूप में व्यवस्थित किया जाता है प्रत्येक के साथ पी वेरिएबल्स के एकल समूहीकृत अवलोकन का प्रतिनिधित्व करना।

- लिखना पंक्ति सदिश के रूप में, प्रत्येक पी तत्वों के साथ।

- पंक्ति सदिशों को आयाम n × p के एकल आव्यूह 'X' में रखें।

- अनुभवजन्य माध्य की गणना करें

- प्रत्येक कॉलम j = 1, ..., p के साथ अनुभवजन्य माध्य खोजें।

- परिकलित माध्य मानों को आयाम p × 1 के अनुभवजन्य माध्य सदिश 'u' में रखें।

- माध्य से विचलन की गणना करें

औसत घटाव प्रमुख अवयव आधार खोजने की दिशा में समाधान का अभिन्न अंग है जो डेटा का अनुमान लगाने की औसत वर्ग त्रुटि को कम करता है।[33] इसलिए हम निम्नानुसार डेटा को केंद्रित करके आगे बढ़ते हैं:

- अनुभवजन्य माध्य सदिश घटाएं डेटा आव्युह X की प्रत्येक पंक्ति से।

- माध्य-घटाए गए डेटा को n × p आव्युह B में संग्रहीत करें।

- जहाँ h है n × 1 सभी 1 का कॉलम सदिश :

कुछ अनुप्रयोगों में, प्रत्येक वेरिएबल (बी का कॉलम) को 1 के समान भिन्नता के लिए स्केल किया जा सकता है (जेड-स्कोर देखें)।[34] यह कदम परिकलित प्रमुख अवयवों को प्रभावित करता है, लेकिन उन्हें विभिन्न वेरिएबल ों को मापने के लिए उपयोग की जाने वाली इकाइयों से स्वतंत्र बनाता है।

- सहप्रसरण आव्युह का पता लगाएं

- आव्युह 'बी' से पी × पी अनुभवजन्य सहप्रसरण आव्युह 'सी' खोजें: कहाँ संयुग्मी स्थानांतरण संकारक है। यदि बी में पूरी तरह से वास्तविक संख्याएं होती हैं, जो कि अनेक अनुप्रयोगों में होती है, तो संयुग्म स्थानान्तरण नियमित स्थानान्तरण के समान होता है।

- प्रयोग करने के पीछे तर्क {{math|n − 1}सहप्रसरण की गणना करने के लिए n के अतिरिक्त } बेसेल का सुधार है।

- सहप्रसरण आव्युह के आइजन्वेक्टर और आइजेनवैल्यू का पता लगाएं

- आइजन्वेक्टर के आव्युह 'V' की गणना करें जो सहसंयोजक आव्युह 'C' को विकर्ण करता है: जहाँ D, C के आइजेनवैल्यू का विकर्ण आव्युह है। इस वेरिएबल ण में सामान्यतः आव्युह के Eigedecomposition के लिए कंप्यूटर-आधारित एल्गोरिथ्म का उपयोग सम्मिलित होगा। ये एल्गोरिदम अधिकांश आव्युह बीजगणित प्रणालियों के उप-अवयवों के रूप में आसानी से उपलब्ध हैं, जैसे एसएएस (सॉफ्टवेयर),[35] आर (प्रोग्रामिंग भाषा), MATLAB,[36][37] गणित,[38] SciPy, IDL (प्रोग्रामिंग लैंग्वेज) (इंटरएक्टिव डेटा भाषा), या GNU ऑक्टेव और साथ ही OpenCV।

- आव्युह डी p × p विकर्ण आव्युह का रूप ले लेगा, जहाँ सहप्रसरण आव्युह 'C' का jवां आइजेनवैल्यू है, और

- आव्युह V, आयाम p × p का भी, p कॉलम वैक्टर, प्रत्येक लंबाई p, जो सहप्रसरण आव्युह के p आइजन्वेक्टर का प्रतिनिधित्व करता है सी।

- आइजेनवैल्यू और आइजन्वेक्टर को क्रमबद्ध और युग्मित किया जाता है। Jth आइजेनवैल्यू jth eigenvector से मेल खाता है।

- आव्युह वी 'राइट' आइजन्वेक्टर के आव्युह को दर्शाता है ('लेफ्ट' आइजन्वेक्टर के विपरीत)। सामान्य तौर पर, दाएं आइजन्वेक्टर के आव्युह को बाएं आइजन्वेक्टर के आव्युह का नहीं होना चाहिए।

- आइजन्वेक्टर ों और ईजेनवैल्यू को पुनर्व्यवस्थित करें

- eigenvector आव्युह V और आइजेनवैल्यू आव्युह D के कॉलम को घटते आइजेनवैल्यू के क्रम में क्रमबद्ध करें।

- प्रत्येक आव्युह में स्तंभों के बीच सही जोड़ियों को बनाए रखना सुनिश्चित करें।

- प्रत्येक आइजन्वेक्टर के लिए संचयी ऊर्जा सामग्री की गणना करें

- आइजेनवैल्यू स्रोत डेटा की ऊर्जा के वितरण का प्रतिनिधित्व करते हैं प्रत्येक आइजन्वेक्टर के बीच, जहाँ आइजन्वेक्टर डेटा के लिए आधार (रैखिक बीजगणित) बनाते हैं। जेवें आइजन्वेक्टर के लिए संचयी ऊर्जा सामग्री जी 1 से जे तक सभी ईजेनवैल्यू में ऊर्जा सामग्री का योग है:

- आधार सदिश के रूप में आइजन्वेक्टर ों के सबसमुच्चय का चयन करें

- 'वी' के पहले एल कॉलम को पी × एल आव्युह 'डब्ल्यू' के रूप में सहेजें: कहाँ

- 'L के लिए उपयुक्त मान चुनने में गाइड के रूप में सदिश g का उपयोग करें। लक्ष्य प्रतिशत के आधार पर g के यथोचित उच्च मूल्य को प्राप्त करते हुए जितना संभव हो सके L के मान को चुनना है। उदाहरण के लिए, आप L चुनना चाह सकते हैं जिससे संचयी ऊर्जा g निश्चित सीमा से ऊपर हो, जैसे 90 प्रतिशत। इस मामले में, 'एल' का सबसे छोटा मान चुनें जैसे कि

- डेटा को नए आधार पर प्रोजेक्ट करें

- अनुमानित डेटा बिंदु आव्युह की पंक्तियाँ हैं

अर्थात का पहला कॉलम पहले प्रमुख अवयव पर डेटा बिंदुओं का प्रक्षेपण है, दूसरा स्तंभ दूसरे प्रमुख अवयव पर प्रक्षेपण है, आदि।

सहप्रसरण विधि का उपयोग करके पीसीए की व्युत्पत्ति

एक्स को कॉलम सदिश के रूप में व्यक्त 'डी'-आयामी यादृच्छिक सदिश होना चाहिए। व्यापकता के नुकसान के बिना, मान लें कि X का शून्य माध्य है।

हम खोजना चाहते हैं a d × d ऑर्थोनॉर्मल आधार पी जिससे पीएक्स में विकर्ण सहप्रसरण आव्युह हो (अर्थात, पीएक्स यादृच्छिक सदिश है जिसके सभी भिन्न -भिन्न अवयव जोड़ीदार असंबद्ध हैं)।

एक त्वरित गणना मानते हुए एकात्मक उपज थे:

इस तरह रखती है अगर और केवल अगर द्वारा विकर्णीय थे .

यह बहुत रचनात्मक है, क्योंकि cov(X) गैर-नकारात्मक निश्चित आव्युह होने की गारंटी है और इस प्रकार कुछ एकात्मक आव्युह द्वारा विकर्ण होने की गारंटी है।

सहप्रसरण-मुक्त संगणना

व्यावहारिक कार्यान्वयन में, विशेष रूप से उच्च आयामी डेटा (बड़े p), भोली सहप्रसरण विधि का उपयोग शायद ही कभी किया जाता है क्योंकि सहप्रसरण आव्युह को स्पष्ट रूप से निर्धारित करने की उच्च कम्प्यूटेशनल और मेमोरी लागत के कारण यह कुशल नहीं है। सहप्रसरण-मुक्त दृष्टिकोण से बचा जाता है np2 स्पष्ट रूप से सहप्रसरण आव्युह की गणना और भंडारण के संचालन XTX, इसके अतिरिक्त आव्युह -मुक्त विधियों में से का उपयोग करना, उदाहरण के लिए, उत्पाद का मूल्यांकन करने वाले फ़ंक्शन के आधार पर XT(X r) की कीमत पर 2np संचालन।

पुनरावृत्ति संगणना

पहले प्रमुख अवयव की कुशलता से गणना करने का तरीका[39] डेटा आव्युह के लिए निम्नलिखित छद्म कोड में दिखाया गया है X शून्य माध्य के साथ, इसके सहप्रसरण आव्युह की गणना किए बिना।

r = लंबाई का यादृच्छिक सदिश p

आर = आर / मानदंड (आर)

करना c बार:

s = 0 (लंबाई का सदिश p) for each row x in X s = s + (x ⋅ r) x λ = rTs // λ is the eigenvalue error = |λ ⋅ r − s| r = s / norm(s) exit if error < tolerance

वापस करना λ, r

यह शक्ति पुनरावृत्ति एल्गोरिथ्म केवल सदिश की गणना करता है XT(X r), सामान्य करता है, और परिणाम को वापस अंदर रखता है r. आइजेनवैल्यू द्वारा अनुमानित है rT (XTX) r, जो इकाई सदिश पर रेले भागफल है r सहप्रसरण आव्युह के लिए XTX . यदि सबसे बड़ा एकवचन मान अगले सबसे बड़े सदिश से अच्छी तरह से भिन्न है r के पहले प्रमुख अवयव के करीब हो जाता है X पुनरावृत्तियों की संख्या के भीतर c, जो के सापेक्ष छोटा है p, कुल लागत पर 2cnp. अधिक उन्नत आव्युह -मुक्त विधियों, जैसे लैंक्ज़ोस एल्गोरिथम या स्थानीय रूप से इष्टतम ब्लॉक प्रीकंडीशन्ड कंजुगेट ग्रेडिएंट (LOBPCG) विधि का उपयोग करके प्रति पुनरावृत्ति की छोटी लागत का त्याग किए बिना शक्ति पुनरावृत्ति अभिसरण को त्वरित किया जा सकता है।

पश्चात के प्रमुख अवयवों की गणना एक-एक करके अपस्फीति के माध्यम से या साथ ब्लॉक के रूप में की जा सकती है। पूर्व दृष्टिकोण में, पहले से ही गणना किए गए अनुमानित प्रमुख अवयवों में अशुद्धियाँ पश्चात में गणना किए गए प्रमुख अवयवों की सटीकता को जोड़ कर प्रभावित करती हैं, इस प्रकार हर नई संगणना के साथ त्रुटि बढ़ जाती है। ब्लॉक पावर पद्धति में पश्चात वाला दृष्टिकोण एकल-सदिश की जगह लेता है r और s ब्लॉक-वैक्टर, मैट्रिसेस के साथ R और S. का हर स्तंभ R प्रमुख प्रमुख अवयवों में से का अनुमान लगाता है, जबकि सभी कॉलम साथ पुनरावृत्त होते हैं। मुख्य गणना उत्पाद का मूल्यांकन है XT(X R). कार्यान्वित, उदाहरण के लिए, LOBPCG में, कुशल अवरोधन त्रुटियों के संचय को समाप्त करता है, उच्च-स्तरीय BLAS आव्युह -आव्युह उत्पाद कार्यों का उपयोग करने की अनुमति देता है, और सामान्यतः एकल-सदिश एक-एक-एक तकनीक की तुलना में तेजी से अभिसरण की ओर जाता है।

NIPALS विधि

गैर-रैखिक पुनरावृत्त आंशिक न्यूनतम वर्ग (NIPALS) प्रमुख अवयव या आंशिक कम वर्ग विश्लेषण में पहले कुछ अवयवों की गणना के लिए घटाव द्वारा आव्युह अपस्फीति के साथ शास्त्रीय शक्ति पुनरावृत्ति का प्रकार है। बहुत उच्च-आयामी डेटासमुच्चय के लिए, जैसे कि *ओमिक्स विज्ञान (उदाहरण के लिए, जीनोमिक्स, चयापचय) में उत्पन्न डेटासमुच्चय के लिए सामान्यतः केवल पहले कुछ पीसी की गणना करना आवश्यक होता है। गैर-रैखिक पुनरावृत्त आंशिक न्यूनतम वर्ग (NIPALS) एल्गोरिथ्म प्रमुख स्कोर और लोडिंग 'टी' के पुनरावृत्त अनुमानों को अद्यतन करता है।1 और आर1T शक्ति पुनरावृत्ति द्वारा प्रत्येक पुनरावृत्ति पर X द्वारा बाईं ओर और दाईं ओर गुणा किया जाता है, अर्थात, सहसंयोजक आव्युह की गणना से बचा जाता है, ठीक उसी तरह जैसे बिजली पुनरावृत्तियों के आव्युह -मुक्त कार्यान्वयन में XTX, उत्पाद का मूल्यांकन करने वाले फ़ंक्शन के आधार पर XT(X r) = ((X r)TX)T.

घटाव द्वारा आव्युह अपस्फीति बाहरी उत्पाद, टी घटाकर किया जाता है1r1T X से अवस्फीत अवशिष्ट आव्युह को छोड़ते हुए पश्चात के प्रमुख पीसी की गणना करने के लिए उपयोग किया जाता है।[40] बड़े डेटा मेट्रिसेस, या मेट्रिसेस के लिए, जिनमें कॉलम कोलीनियरिटी का उच्च स्तर होता है, NIPALS पीसी की ऑर्थोगोनलिटी के नुकसान से ग्रस्त होता है, क्योंकि प्रत्येक पुनरावृत्ति और आव्युह अपस्फीति में घटाव द्वारा संचित मशीन सटीक राउंड-ऑफ त्रुटियां होती हैं।[41] ऑर्थोगोनलिटी के इस नुकसान को खत्म करने के लिए प्रत्येक पुनरावृत्ति वेरिएबल ण पर स्कोर और लोडिंग दोनों के लिए ग्राम-श्मिट री-ऑर्थोगोनलाइज़ेशन एल्गोरिदम लागू किया जाता है।[42] एकल-सदिश गुणन पर NIPALS निर्भरता उच्च-स्तरीय BLAS का लाभ नहीं उठा सकती है और परिणामस्वरूप क्लस्टर अग्रणी विलक्षण मूल्यों के लिए धीमी गति से अभिसरण होता है - इन दोनों कमियों को अधिक परिष्कृत आव्युह -मुक्त ब्लॉक सॉल्वर में हल किया जाता है, जैसे कि स्थानीय रूप से इष्टतम ब्लॉक प्रीकंडिशनेड कंजुगेट ग्रेडिएंट ( एलओबीपीसीजी) विधि।

ऑनलाइन/अनुक्रमिक अनुमान

एक ऑनलाइन या स्ट्रीमिंग स्थिति में बैच में संग्रहीत होने के अतिरिक्त टुकड़े-टुकड़े डेटा आने के साथ, पीसीए प्रोजेक्शन का अनुमान लगाना उपयोगी होता है जिसे क्रमिक रूप से अपडेट किया जा सकता है। यह कुशलता से किया जा सकता है, लेकिन इसके लिए भिन्न -भिन्न एल्गोरिदम की आवश्यकता होती है।[43]

पीसीए और गुणात्मक वेरिएबल

पीसीए में, यह सामान्य है कि हम गुणात्मक वेरिएबल को पूरक तत्वों के रूप में पेश करना चाहते हैं। उदाहरण के लिए, पौधों पर अनेक मात्रात्मक वेरिएबल ों को मापा गया है। इन पौधों के लिए, कुछ गुणात्मक वेरिएबल उपलब्ध हैं, उदाहरण के लिए, वह प्रजाति जिससे पौधे संबंधित हैं। ये डेटा मात्रात्मक वेरिएबल के लिए पीसीए के अधीन थे। परिणामों का विश्लेषण करते समय, प्रमुख अवयवों को गुणात्मक वेरिएबल प्रजातियों से जोड़ना स्वाभाविक है। इसके लिए निम्न परिणाम प्राप्त होते हैं।

- विभिन्न प्रजातियों की पहचान, तथ्यात्मक विमानों पर, उदाहरण के लिए, विभिन्न रंगों का उपयोग करना।

- प्रतिनिधित्व, ही प्रजाति से संबंधित पौधों के गुरुत्वाकर्षण के केंद्रों के तथ्यात्मक विमानों पर।

- गुरुत्वाकर्षण के प्रत्येक केंद्र और प्रत्येक अक्ष के लिए, गुरुत्व केंद्र और उत्पत्ति के बीच के अंतर के महत्व का न्याय करने के लिए पी-मान।

इन परिणामों को गुणात्मक वेरिएबल को पूरक तत्व के रूप में प्रस्तुत करना कहा जाता है। यह प्रक्रिया Husson, Lê & Pages 2009 और Pages 2013 में विस्तृत है। कुछ सॉफ्टवेयर इस विकल्प को स्वचालित तरीके से पेश करते हैं। यह SPAD का मामला है, जो ऐतिहासिक रूप से, लुडोविक लेबार्ट के काम के पश्चात , इस विकल्प और R पैकेज को प्रस्तावित करने वाले पहले व्यक्ति थे फैक्टोमाइनर।

अनुप्रयोग

बुद्धि

कारक विश्लेषण का सबसे पहला प्रयोग मानव बुद्धि के अवयवों का पता लगाने और मापने में था। यह माना जाता था कि बुद्धि में विभिन्न असंबद्ध अवयव होते हैं जैसे कि स्थानिक बुद्धि, मौखिक बुद्धि, आगमन, कटौती आदि और इन पर अंक विभिन्न परीक्षणों के परिणामों से कारक विश्लेषण द्वारा जोड़े जा सकते हैं, जिससे एकल सूचकांक दिया जा सके जिसे खुफिया भागफल (IQ) के रूप में जाना जाता है। ). अग्रणी सांख्यिकीय मनोवैज्ञानिक चार्ल्स स्पीयरमैन ने वास्तव में 1904 में अपने बुद्धि के दो-कारक सिद्धांत | बुद्धि के दो-कारक सिद्धांत के लिए कारक विश्लेषण विकसित किया, जिसमें साइकोमेट्रिक्स के विज्ञान के लिए औपचारिक तकनीक सम्मिलित थी। 1924 में लुई लियोन थर्स्टन ने मानसिक आयु की धारणा को विकसित करते हुए बुद्धि के 56 कारकों की तलाश की। मानक IQ परीक्षण आज इसी प्रारंभिक कार्य पर आधारित हैं।[44]

आवासीय भेदभाव

1949 में, शेवकी और विलियम्स ने फैक्टोरियल इकोलॉजी का सिद्धांत पेश किया, जो 1950 से 1970 के दशक तक आवासीय भेदभाव के अध्ययन पर हावी था।[45] शहर में आस-पड़ोस पहचानने योग्य थे या विभिन्न विशेषताओं द्वारा दूसरे से भिन्न किए जा सकते थे जिन्हें कारक विश्लेषण द्वारा घटाकर तीन किया जा सकता था। इन्हें 'सामाजिक पद' (व्यावसायिक स्थिति का सूचकांक), 'परिवारवाद' या परिवार का आकार, और 'जातीयता' के रूप में जाना जाता था; क्लस्टर विश्लेषण को तीन प्रमुख कारक वेरिएबल के मूल्यों के अनुसार शहर को क्लस्टर या परिसर में विभाजित करने के लिए लागू किया जा सकता है। शहरी भूगोल में फैक्टोरियल इकोलॉजी के आसपास व्यापक साहित्य विकसित हुआ, लेकिन 1980 के पश्चात पद्धतिगत रूप से आदिम होने और उत्तर आधुनिक भौगोलिक प्रतिमानों में कम जगह होने के कारण यह दृष्टिकोण फैशन से बाहर हो गया।

कारक विश्लेषण की समस्याओं में से हमेशा विभिन्न कृत्रिम कारकों के लिए ठोस नाम खोजना रहा है। 2000 में, फ्लड ने फैक्टोरियल इकोलॉजी दृष्टिकोण को पुनर्जीवित किया, यह दिखाने के लिए कि प्रमुख अवयव विश्लेषण ने कारक रोटेशन का सहारा लिए बिना वास्तव में सीधे सार्थक उत्तर दिए। प्रमुख अवयव वास्तव में शहरों में लोगों को साथ या भिन्न करने वाले 'बलों' के दोहरे वेरिएबल या छाया मूल्य थे। पहला अवयव 'पहुंच' था, यात्रा की मांग और अंतरिक्ष की मांग के बीच क्लासिक व्यापार-बंद, जिसके आसपास शास्त्रीय शहरी अर्थशास्त्र आधारित है। अगले दो अवयव 'नुकसान' थे, जो समान स्थिति के लोगों को भिन्न पड़ोस (नियोजन द्वारा मध्यस्थता) में रखता है, और जातीयता, जहां समान जातीय पृष्ठभूमि के लोग सह-पता लगाने की कोशिश करते हैं।[46] उसी समय के बारे में, ऑस्ट्रेलियाई सांख्यिकी ब्यूरो ने प्रमुख वेरिएबल के समुच्चय के पहले प्रमुख अवयव को लेते हुए लाभ और हानि के भिन्न -भिन्न सूचकांकों को परिभाषित किया, जिन्हें महत्वपूर्ण माना गया था। ये SEIFA इंडेक्स नियमित रूप से विभिन्न न्यायालयों के लिए प्रकाशित होते हैं, और स्थानिक विश्लेषण में अधिकतर उपयोग किए जाते हैं।[47]

विकास सूचकांक

पीसीए इंडेक्स के विकास के लिए उपलब्ध एकमात्र औपचारिक विधि रहा है, जो अन्यथा हिट-या-मिस तदर्थ उपक्रम है।

नगर विकास सूचकांक पीसीए द्वारा 1996 में 254 वैश्विक शहरों के सर्वेक्षण में शहर के परिणामों के लगभग 200 संकेतकों से विकसित किया गया था। पहला प्रमुख अवयव पुनरावृत्त प्रतिगमन के अधीन था, मूल वेरिएबल को तब तक जोड़ा गया जब तक कि इसकी लगभग 90% भिन्नता का हिसाब नहीं लगाया गया। इंडेक्स ने अंततः लगभग 15 संकेतकों का उपयोग किया लेकिन अनेक और वेरिएबल ों का अच्छा भविष्यवक्ता था। इसका तुलनात्मक मूल्य प्रत्येक शहर की स्थिति के व्यक्तिपरक मूल्यांकन के साथ बहुत अच्छी तरह से मेल खाता है। बुनियादी ढांचे की वस्तुओं पर गुणांक अंतर्निहित सेवाएं प्रदान करने की औसत लागत के लगभग आनुपातिक थे, यह सुझाव देते हुए कि सूचकांक वास्तव में शहर में प्रभावी भौतिक और सामाजिक निवेश का उपाय था।

संयुक्त राष्ट्र विकास कार्यक्रम से देश-स्तरीय मानव विकास सूचकांक (एचडीआई), जो 1990 से प्रकाशित हुआ है और विकास अध्ययनों में बहुत व्यापक रूप से उपयोग किया जाता है,[48] समान संकेतकों पर बहुत समान गुणांक हैं, यह दृढ़ता से सुझाव देते हैं कि यह मूल रूप से पीसीए का उपयोग करके बनाया गया था।

जनसंख्या आनुवंशिकी

1978 में लुइगी लुका कवेली-स्फोर्ज़ा | कैवली-स्फोर्ज़ा और अन्य ने क्षेत्रों में मानव जीन आवृत्तियों में भिन्नता पर डेटा को सारांशित करने के लिए प्रमुख अवयव विश्लेषण (पीसीए) के उपयोग का बीड़ा उठाया। अवयवों ने विशिष्ट पैटर्न दिखाए, जिनमें ग्रेडियेंट और साइनसॉइडल तरंगें सम्मिलित हैं। उन्होंने विशिष्ट प्राचीन प्रवासन घटनाओं के परिणामस्वरूप इन प्रतिमानों की व्याख्या की।

तब से, पीसीए प्रदर्शन तंत्र के रूप में पीसीए का उपयोग करने वाले हजारों कागजों के साथ जनसंख्या आनुवंशिकी में सर्वव्यापी रहा है। निकटता के अनुसार आनुवंशिकी काफी हद तक भिन्न होती है, इसलिए पहले दो प्रमुख अवयव वास्तव में स्थानिक वितरण दिखाते हैं और इसका उपयोग विभिन्न जनसंख्या समूहों के सापेक्ष भौगोलिक स्थान को मानचित्र करने के लिए किया जा सकता है, जिससे ऐसे व्यक्तियों को दिखाया जा सकता है जो अपने मूल स्थानों से भटक गए हैं।[49] जेनेटिक्स में पीसीए तकनीकी रूप से विवादास्पद रहा है, जिसमें तकनीक असतत गैर-सामान्य वेरिएबल और अधिकतर बाइनरी एलील मार्करों पर की गई है। पीसीए में मानक त्रुटि के किसी भी उपाय की कमी भी अधिक सुसंगत उपयोग के लिए बाधा है। अगस्त 2022 में, आणविक जीवविज्ञानी ईरान जोड़ा गया ने 12 पीसीए अनुप्रयोगों का विश्लेषण करते हुए वैज्ञानिक रिपोर्ट में सैद्धांतिक पेपर प्रकाशित किया। उन्होंने निष्कर्ष निकाला कि विधि में हेरफेर करना आसान था, जो, उनके विचार में, 'गलत, विरोधाभासी और बेतुका' परिणाम उत्पन्न करता था। विशेष रूप से, उन्होंने तर्क दिया, जनसंख्या आनुवंशिकी में प्राप्त परिणाम चेरी-पिकिंग और सर्कुलर तर्क द्वारा विशेषता थे।[50]

बाजार अनुसंधान और दृष्टिकोण के सूचकांक

बाजार अनुसंधान पीसीए का व्यापक उपयोगकर्ता रहा है। इसका उपयोग उत्पादों के लिए ग्राहकों की संतुष्टि या ग्राहक वफादारी स्कोर विकसित करने के लिए किया जाता है, और क्लस्टरिंग के साथ, बाजार खंडों को विकसित करने के लिए विज्ञापन अभियानों के साथ लक्षित किया जा सकता है, ठीक उसी तरह जैसे फैक्टोरियल इकोलॉजी समान विशेषताओं वाले भौगोलिक क्षेत्रों का पता लगाएगी।[51] पीसीए तेजी से बड़ी मात्रा में डेटा को छोटे, आसानी से पचने वाले वेरिएबल में बदल देता है जिसे अधिक तेजी से और आसानी से विश्लेषण किया जा सकता है। किसी भी उपभोक्ता प्रश्नावली में, उपभोक्ता के दृष्टिकोण को जानने के लिए डिज़ाइन किए गए प्रश्नों की श्रृंखला होती है, और प्रमुख अवयव इन दृष्टिकोणों के अंतर्निहित अव्यक्त वेरिएबल की तलाश करते हैं। उदाहरण के लिए, 2013 में ऑक्सफोर्ड इंटरनेट सर्वेक्षण ने 2000 लोगों से उनके दृष्टिकोण और विश्वासों के बारे में पूछा, और इन विश्लेषकों से चार प्रमुख अवयव आयाम निकाले, जिन्हें उन्होंने 'एस्केप', 'सोशल नेटवर्किंग', 'दक्षता' और 'समस्या पैदा करने' के रूप में पहचाना। .[52] 2008 में जो फ्लड (नीति विश्लेषक) के अन्य उदाहरण ने ऑस्ट्रेलिया में 2697 परिवारों के राष्ट्रीय सर्वेक्षण में 28 दृष्टिकोण प्रश्नों से आवास के प्रति व्यवहारिक सूचकांक निकाला। पहला प्रमुख अवयव संपत्ति और घर के स्वामित्व के प्रति सामान्य दृष्टिकोण का प्रतिनिधित्व करता है। अनुक्रमणिका, या इसके सन्निहित अभिवृत्ति प्रश्न, कार्यकाल पसंद के सामान्य रेखीय मॉडल में डाले जा सकते हैं। आय, वैवाहिक स्थिति या घरेलू प्रकार के अतिरिक्त अब तक निजी किराये का सबसे मजबूत निर्धारक रवैया सूचकांक था।[53]

मात्रात्मक वित्त

मात्रात्मक वित्त में, प्रमुख अवयव विश्लेषण सीधे ब्याज दर डेरिवेटिव पोर्टफोलियो के जोखिम प्रबंधन पर लागू किया जा सकता है।[54] ट्रेडिंग मल्टीपल स्वैप (वित्त) जो आम तौर पर 30-500 अन्य बाजार उद्धृत योग्य स्वैप उपकरणों का कार्य है, को सामान्यतः 3 या 4 प्रमुख अवयवों तक कम करने की मांग की जाती है, जो मैक्रो आधार पर ब्याज दरों के मार्ग का प्रतिनिधित्व करते हैं। फैक्टर लोडिंग (या मल्टीप्लायर) के रूप में प्रतिनिधित्व किए जाने वाले जोखिमों को परिवर्तित करना व्यक्तिगत 30–500 बकेट के जोखिमों को सामूहिक रूप से देखने के लिए उपलब्ध से परे आकलन और समझ प्रदान करता है।

पीसीए को भंडार पर भी इसी तरह से लागू किया गया है,[55] जोखिम वापसी अनुपात और जोखिम-प्रतिफल स्पेक्ट्रम दोनों के लिए। आवेदन पोर्टफोलियो जोखिम को कम करना है, जहां परिसंपत्ति आवंटन अंतर्निहित शेयरों के अतिरिक्त प्रमुख पोर्टफोलियो पर लागू होता है।[56] दूसरा, पोर्टफोलियो रिटर्न को बढ़ाने के लिए प्रमुख अवयवों का उपयोग स्टॉक चयन मानदंड के साथ ऊपर की क्षमता के साथ करना है।

तंत्रिका विज्ञान

प्रमुख अवयव विश्लेषण के प्रकार का उपयोग तंत्रिका विज्ञान में उत्तेजना के विशिष्ट गुणों की पहचान करने के लिए किया जाता है जो न्यूरॉन की क्रिया क्षमता उत्पन्न करने की संभावना को बढ़ाता है।[57][58] इस तकनीक को स्पाइक-ट्रिगर सहप्रसरण|स्पाइक-ट्रिगर सहप्रसरण विश्लेषण के रूप में जाना जाता है। विशिष्ट अनुप्रयोग में प्रयोगकर्ता सफेद ध्वनि प्रक्रिया को उत्तेजना के रूप में प्रस्तुत करता है (सामान्यतः या तो परीक्षण विषय के लिए संवेदी इनपुट के रूप में, या विद्युत प्रवाह के रूप में सीधे न्यूरॉन में इंजेक्ट किया जाता है) और एक्शन पोटेंशिअल या स्पाइक्स की ट्रेन रिकॉर्ड करता है, जो उत्पादित होता है। परिणामस्वरूप न्यूरॉन। संभवतः, उत्तेजना की कुछ विशेषताएं न्यूरॉन को स्पाइक करने की अधिक संभावना बनाती हैं। इन सुविधाओं को निकालने के लिए, प्रयोगकर्ता स्पाइक-ट्रिगर किए गए कलाकारों की टुकड़ी के सहप्रसरण आव्युह की गणना करता है, सभी उत्तेजनाओं का समुच्चय (सामान्यतः 100 एमएस के क्रम में परिमित समय खिड़की पर परिभाषित और विघटित) जो तुरंत स्पाइक से पहले होता है। स्पाइक-ट्रिगर सहप्रसरण आव्युह और पूर्व उत्तेजना पहनावा के सहप्रसरण आव्युह के बीच अंतर के आइजन्वेक्टर और ईगेनवेल्यूज़ (सभी उत्तेजनाओं का समुच्चय , समान लंबाई समय विंडो पर परिभाषित) फिर उत्तेजनाओं के सदिश स्थान में दिशाओं का संकेत देते हैं जिसके साथ स्पाइक-ट्रिगर पहनावा का विचरण पूर्व प्रोत्साहन पहनावा से सबसे भिन्न था। विशेष रूप से, सबसे बड़े सकारात्मक आइजेनवैल्यू वाले आइजन्वेक्टर उन दिशाओं के अनुरूप होते हैं जिनके साथ स्पाइक-ट्रिगर पहनावा के विचरण ने पूर्व के विचरण की तुलना में सबसे बड़ा सकारात्मक परिवर्तन दिखाया। चूँकि ये वे दिशाएँ थीं जिनमें भिन्न -भिन्न उत्तेजनाओं ने स्पाइक का नेतृत्व किया, वे अधिकतर प्रासंगिक उत्तेजना सुविधाओं के पश्चात की मांग के अच्छे अनुमान हैं।

तंत्रिका विज्ञान में, पीसीए का उपयोग न्यूरॉन की पहचान को उसकी क्रिया क्षमता के आकार से पहचानने के लिए भी किया जाता है। स्पाइक छँटाई महत्वपूर्ण प्रक्रिया है क्योंकि इलेक्ट्रोफिजियोलॉजी#बाह्यकोशिकीय रिकॉर्डिंग रिकॉर्डिंग तकनीकें अधिकतर से अधिक न्यूरॉन से संकेत लेती हैं। स्पाइक छँटाई में, पहले पीसीए का उपयोग एक्शन पोटेंशियल वेवफॉर्म के स्थान की गतिशीलता को कम करने के लिए किया जाता है, और फिर व्यक्तिगत न्यूरॉन्स के साथ विशिष्ट एक्शन पोटेंशिअल को जोड़ने के लिए क्लस्टर विश्लेषण किया जाता है।

पीसीए आयाम कमी तकनीक के रूप में विशेष रूप से बड़े न्यूरोनल पहनावा की समन्वित गतिविधियों का पता लगाने के लिए अनुकूल है। यह मस्तिष्क में वेरिएबल ण संक्रमण के दौरान सामूहिक वेरिएबल , अर्थात आदेश पैरामीटर निर्धारित करने में उपयोग किया गया है।[59]

अन्य विधियों के साथ संबंध

पत्राचार विश्लेषण

पत्राचार विश्लेषण (सीए) जीन-पॉल बेंजेक्री द्वारा विकसित किया गया था[60] और वैचारिक रूप से पीसीए के समान है, लेकिन डेटा को मापता है (जो गैर-नकारात्मक होना चाहिए) जिससे पंक्तियों और स्तंभों को समान रूप से व्यवहार किया जा सके। यह परंपरागत रूप से आकस्मिक तालिकाओं पर लागू होता है। CA इस तालिका से जुड़े ची-स्क्वायर आँकड़ों को ऑर्थोगोनल कारकों में विघटित करता है।[61] क्योंकि CA वर्णनात्मक तकनीक है, इसे उन तालिकाओं पर लागू किया जा सकता है जिनके लिए ची-स्क्वेर्ड आँकड़ा उपयुक्त है या नहीं। सीए के अनेक प्रकार उपलब्ध हैं जिनमें डिट्रेंडेड पत्राचार विश्लेषण और कैनोनिकल पत्राचार विश्लेषण सम्मिलित हैं। विशेष विस्तार एकाधिक पत्राचार विश्लेषण है, जिसे श्रेणीबद्ध डेटा के लिए प्रमुख अवयव विश्लेषण के समकक्ष के रूप में देखा जा सकता है।[62]

कारक विश्लेषण

प्रमुख कंपोनेंट विश्लेषण वेरिएबल्स बनाता है जो मूल वेरिएबल्स के रैखिक संयोजन हैं। नए वेरिएबल्स में यह संपत्ति है कि वेरिएबल्स सभी ऑर्थोगोनल हैं। पीसीए परिवर्तन क्लस्टरिंग से पहले प्री-प्रोसेसिंग वेरिएबल ण के रूप में सहायक हो सकता है। पीसीए भिन्नता-केंद्रित दृष्टिकोण है जो कुल परिवर्तनीय भिन्नता को पुन: उत्पन्न करने की मांग करता है, जिसमें अवयव वेरिएबल के सामान्य और अद्वितीय भिन्नता दोनों को दर्शाते हैं। पीसीए को आम तौर पर डेटा में कमी के प्रयोजनों के लिए पसंद किया जाता है (अर्थात, वेरिएबल स्थान को इष्टतम कारक स्थान में अनुवाद करना) लेकिन तब नहीं जब लक्ष्य अव्यक्त निर्माण या कारकों का पता लगाना हो।

कारक विश्लेषण प्रमुख अवयव विश्लेषण के समान है, उस कारक विश्लेषण में वेरिएबल के रैखिक संयोजन भी सम्मिलित हैं। पीसीए से भिन्न , कारक विश्लेषण सहसंबंध-केंद्रित दृष्टिकोण है जो वेरिएबल के बीच अंतर-सहसंबंधों को पुन: उत्पन्न करने की मांग करता है, जिसमें कारक वेरिएबल के सामान्य भिन्नता का प्रतिनिधित्व करते हैं, अद्वितीय भिन्नता को छोड़कर।[63] सहसंबंध आव्युह के संदर्भ में, यह ऑफ-डायगोनल शर्तों (अर्थात , साझा सह-विचरण ) को समझाने पर ध्यान केंद्रित करने के अनुरूप है, जबकि पीसीए विकर्ण पर बैठने वाली शर्तों को समझाने पर ध्यान केंद्रित करता है। चूँकि , साइड परिणाम के रूप में, ऑन-डायगोनल शर्तों को पुन: पेश करने की कोशिश करते समय, पीसीए भी ऑफ-डायगोनल सहसंबंधों को अपेक्षाकृत अच्छी तरह से फिट करने की कोशिश करता है।[12]: 158 पीसीए और कारक विश्लेषण द्वारा दिए गए परिणाम ज्यादातर स्थितियों में बहुत समान होते हैं, लेकिन हमेशा ऐसा नहीं होता है, और कुछ समस्याएं ऐसी होती हैं जहां परिणाम महत्वपूर्ण रूप से भिन्न होते हैं। कारक विश्लेषण का सामान्यतः उपयोग तब किया जाता है जब अनुसंधान उद्देश्य डेटा संरचना (अर्थात, अव्यक्त निर्माण या कारक) या कारण मॉडलिंग का पता लगा रहा हो। यदि कारक मॉडल गलत तरीके से तैयार किया गया है या मान्यताओं को पूरा नहीं किया गया है, तो कारक विश्लेषण गलत परिणाम देगा।[64]

K-मतलब क्लस्टरिंग

यह दावा किया गया है कि के-मतलब क्लस्टरिंग का आराम समाधानk-मतलब क्लस्टरिंग, क्लस्टर संकेतक द्वारा निर्दिष्ट, प्रमुख अवयवों द्वारा दिया जाता है, और मुख्य दिशाओं द्वारा फैला हुआ पीसीए सबस्पेस क्लस्टर सेंट्रोइड सबस्पेस के समान है।[65][66] हालाँकि, वह पीसीए की उपयोगी छूट है k-मतलब क्लस्टरिंग नया परिणाम नहीं था,[67] और इस कथन के प्रतिउदाहरणों को उजागर करना सीधा है कि क्लस्टर सेंट्रोइड उप-स्थान प्रमुख दिशाओं द्वारा फैला हुआ है।[68]

गैर-नकारात्मक आव्युह गुणन

फ़ाइल: आंशिक अवशिष्ट भिन्नता तुलना, पीसीए और एनएमएफ.pdf|thumb|500px|पीसीए और एनएमएफ के लिए आंशिक अवशिष्ट भिन्नता (FRV) भूखंड;[24]पीसीए के लिए, सैद्धांतिक मूल्य अवशिष्ट आइजेनवैल्यू से योगदान है। इसकी तुलना में, पीसीए के लिए एफआरवी घटता सपाट पठार तक पहुंचता है जहां कोई संकेत प्रभावी ढंग से नहीं पकड़ा जाता है; जबकि NMF FRV घटता लगातार गिर रहा है, जो संकेत पकड़ने की बेहतर क्षमता का संकेत देता है। NMF के लिए FRV घटता भी पीसीए की तुलना में उच्च स्तर पर परिवर्तित होता है, जो NMF की कम-ओवरफिटिंग संपत्ति को दर्शाता है। गैर-नकारात्मक आव्युह कारककरण (एनएमएफ) आयाम कमी विधि है जहां आव्युह में केवल गैर-नकारात्मक तत्वों का उपयोग किया जाता है, जो कि खगोल विज्ञान में आशाजनक विधि है,[22][23][24]इस अर्थ में कि ज्योतिषीय संकेत गैर-नकारात्मक हैं। पीसीए अवयव दूसरे के लिए ओर्थोगोनल हैं, जबकि एनएमएफ अवयव सभी गैर-नकारात्मक हैं और इसलिए गैर-ऑर्थोगोनल आधार बनाते हैं।

पीसीए में, प्रत्येक अवयव के योगदान को उसके संबंधित आइजेनवैल्यू के परिमाण के आधार पर रैंक किया जाता है, जो कि अनुभवजन्य डेटा का विश्लेषण करने में भिन्नात्मक अवशिष्ट विचरण (FRV) के समान है।[20] NMF के लिए, इसके अवयवों को केवल अनुभवजन्य FRV वक्रों के आधार पर रैंक किया गया है।[24] अवशिष्ट भिन्नात्मक आइजेनवैल्यू भूखंड, अर्थात, अवयव संख्या के समारोह के रूप में कुल दिया घटक, पीसीए के लिए सपाट पठार है, जहां अर्ध-स्थैतिक ध्वनि को दूर करने के लिए कोई डेटा कैप्वेरिएबल नहीं किया जाता है, फिर ओवर-फिटिंग के संकेत के रूप में घटता जल्दी से गिर जाता है और यादृच्छिक ध्वनि को पकड़ लेता है।[20]NMF के लिए FRV घटता लगातार घट रहा है[24]जब NMF अवयवों का निर्माण किया जाता है तो गैर-नकारात्मक आव्युह गुणन#अनुक्रमिक NMF,[23] अर्ध-स्थैतिक ध्वनि के निरंतर कैप्वेरिएबल िंग का संकेत; फिर पीसीए की तुलना में उच्च स्तर पर अभिसरण करें,[24]NMF की कम ओवरफिटिंग संपत्ति का संकेत।

सहसंबंधों की प्रतीकात्मकता

मुख्य अवयवों की व्याख्या करना अधिकतर मुश्किल होता है जब डेटा में विभिन्न उत्पत्ति के अनेक वेरिएबल सम्मिलित होते हैं, या जब कुछ वेरिएबल गुणात्मक होते हैं। यह पीसीए उपयोगकर्ता को अनेक वेरिएबल ों के नाजुक उन्मूलन की ओर ले जाता है। यदि टिप्पणियों या वेरिएबल का अक्षों की दिशा पर अत्यधिक प्रभाव पड़ता है, तो उन्हें हटा दिया जाना चाहिए और फिर पूरक तत्वों के रूप में प्रक्षेपित किया जाना चाहिए। इसके अलावा, फैक्टोरियल प्लेन के केंद्र के करीब बिंदुओं के बीच की निकटता की व्याख्या करने से बचना आवश्यक है।

इसके विपरीत, सहसंबंधों की प्रतिमा, जो कुल्हाड़ियों की प्रणाली पर प्रक्षेपण नहीं है, में ये कमियां नहीं हैं। इसलिए हम सभी वेरिएबल रख सकते हैं।

आरेख का सिद्धांत ठोस रेखा (सकारात्मक सहसंबंध) या बिंदीदार रेखा (नकारात्मक सहसंबंध) द्वारा सहसंबंध आव्युह के उल्लेखनीय सहसंबंधों को रेखांकित करना है।

एक मजबूत सहसंबंध उल्लेखनीय नहीं है यदि यह प्रत्यक्ष नहीं है, लेकिन तीसरे वेरिएबल के प्रभाव के कारण होता है। इसके विपरीत, कमजोर सहसंबंध उल्लेखनीय हो सकते हैं। उदाहरण के लिए, यदि वेरिएबल Y अनेक स्वतंत्र वेरिएबल ों पर निर्भर करता है, तो उनमें से प्रत्येक के साथ Y का सहसंबंध कमजोर और फिर भी उल्लेखनीय है।

सामान्यीकरण

विरल पीसीए

पीसीए का विशेष नुकसान यह है कि प्रमुख अवयव सामान्यतः सभी इनपुट वेरिएबल ों के रैखिक संयोजन होते हैं। विरल पीसीए केवल कुछ इनपुट वेरिएबल वाले रैखिक संयोजनों को ढूंढकर इस नुकसान को दूर करता है। यह इनपुट वेरिएबल्स पर स्पार्सिटी बाधा जोड़कर डेटा की डायमेंशनलिटी को कम करने के लिए प्रमुख कंपोनेंट विश्लेषण (पीसीए) की क्लासिक पद्धति का विस्तार करता है। सहित अनेक दृष्टिकोण प्रस्तावित किए गए हैं

- एक प्रतिगमन ढांचा,[69]

- एक उत्तल छूट / अर्ध-परिमित प्रोग्रामिंग ढांचा,[70]

- एक सामान्यीकृत शक्ति विधि ढांचा[71]

- एक वैकल्पिक अधिकतमकरण ढांचा[72]

- शाखा-और-बाध्य तकनीकों का उपयोग करके आगे-पीछे लालची खोज और सटीक तरीके,[73]

- बायेसियन फॉर्मूलेशन फ्रेमवर्क।[74]

स्पार्स पीसीए के पद्धतिगत और सैद्धांतिक विकास के साथ-साथ वैज्ञानिक अध्ययनों में इसके अनुप्रयोगों की हाल ही में सर्वेक्षण पत्र में समीक्षा की गई थी।[75]

नॉनलाइनियर पीसीए

गैर-रैखिक आयामीता में कमी के अधिकांश आधुनिक तरीके पीसीए या के-साधनों में अपनी सैद्धांतिक और एल्गोरिथम जड़ें पाते हैं। पियर्सन का मूल विचार सीधी रेखा (या समतल) लेना था जो डेटा बिंदुओं के समुच्चय के लिए सबसे उपयुक्त होगा। ट्रेवर हैस्टी ने प्रमुख वक्र ्स को प्रस्तावित करके इस अवधारणा पर विस्तार किया[79] पीसीए की ज्यामितीय व्याख्या के लिए प्राकृतिक विस्तार के रूप में, जो स्पष्ट रूप से प्रोजेक्शन (गणित) के पश्चात डेटा सन्निकटन के लिए अनेक गुना निर्माण करता है, जैसा कि अंजीर में दिखाया गया है।

इलास्टिक मानचित्र एल्गोरिथम प्रमुख जियोडेसिक विश्लेषण विश्लेषण भी देखें।[80] अन्य लोकप्रिय सामान्यीकरण कर्नेल पीसीए है, जो सकारात्मक निश्चित कर्नेल से जुड़े प्रजनन कर्नेल हिल्बर्ट स्पेस में किए गए पीसीए से मेल खाता है।

बहुरेखीय उप-स्थान सीखना में,[81][82][83] पीसीए को बहुरेखीय प्रमुख अवयव विश्लेषण (एमपीसीए) के लिए सामान्यीकृत किया गया है जो सीधे टेंसर प्रस्तुतियों से सुविधाओं को निकालता है। Mपीसीए को टेंसर के प्रत्येक मोड में पुनरावृत्त रूप से पीसीए करके हल किया जाता है। एमपीसीए को चेहरे की पहचान, चाल की पहचान आदि के लिए लागू किया गया है। एमपीसीए को आगे असंबद्ध एमपीसीए, गैर-नकारात्मक एमपीसीए और मजबूत एमपीसीए तक बढ़ाया गया है।

टकर अपघटन, PARAFAC, बहु-कारक विश्लेषण, सह-जड़ता विश्लेषण, STATIS और DISTATIS जैसे मॉडलों के साथ N-way प्रमुख अवयव विश्लेषण किया जा सकता है।

मजबूत पीसीए

जबकि पीसीए गणितीय रूप से इष्टतम विधि (चुकता त्रुटि को कम करने के रूप में) पाता है, यह अभी भी डेटा में ग़ैर के प्रति संवेदनशील है जो बड़ी त्रुटियां उत्पन्न करता है, कुछ ऐसा जो विधि पहले स्थान से बचने की कोशिश करती है। इसलिए पीसीए की गणना करने से पहले आउटलेयर को हटाना आम बात है। हालाँकि, कुछ संदर्भों में, आउटलेयर को पहचानना मुश्किल हो सकता है। उदाहरण के लिए, डेटा खनन एल्गोरिदम जैसे सहसंबंध क्लस्टरिंग में, क्लस्टर और आउटलेयर को पॉइंट्स का असाइनमेंट पहले से ज्ञात नहीं है। पीसीए का हाल ही में प्रस्तावित सामान्यीकरण[84] भारित पीसीए के आधार पर डेटा ऑब्जेक्ट्स को उनकी अनुमानित प्रासंगिकता के आधार पर भिन्न -भिन्न भार देकर मजबूती बढ़ जाती है।

एल1-नॉर्म फॉर्मूलेशन (L1-मानक प्रमुख अवयव विश्लेषण | एल1-पीसीए) के आधार पर पीसीए के बाहरी-प्रतिरोधी वेरिएंट भी प्रस्तावित किए गए हैं।[6][4]

मजबूत प्रमुख अवयव विश्लेषण (Rपीसीए ) निम्न-श्रेणी और विरल मैट्रिसेस में अपघटन के माध्यम से पीसीए का संशोधन है जो व्यापक रूप से दूषित टिप्पणियों के संबंध में अच्छी तरह से काम करता है।[85][86][87]

समान तकनीकें

स्वतंत्र अवयव विश्लेषण

स्वतंत्र अवयव विश्लेषण (आईसीए) को प्रमुख अवयव विश्लेषण के समान समस्याओं के लिए निर्देशित किया जाता है, लेकिन क्रमिक अनुमानों के अतिरिक्त योगात्मक रूप से वियोज्य अवयवों को ढूंढता है।

नेटवर्क अवयव विश्लेषण

एक आव्युह दिया , यह इसे दो मैट्रिसेस में विघटित करने की कोशिश करता है . पीसीए और आईसीए जैसी तकनीकों से महत्वपूर्ण अंतर यह है कि कुछ प्रविष्टियां 0. यहाँ विवश हैं नियामक परत कहा जाता है। जबकि सामान्य तौर पर इस तरह के अपघटन के अनेक समाधान हो सकते हैं, वे साबित करते हैं कि यदि निम्नलिखित शर्तें पूरी होती हैं:

- पूर्ण स्तंभ रैंक है

- का प्रत्येक स्तंभ कम से कम होना चाहिए शून्य कहाँ के स्तंभों की संख्या है (या वैकल्पिक रूप से पंक्तियों की संख्या ). इस मानदंड के लिए औचित्य यह है कि यदि नोड को विनियामक परत से हटा दिया जाता है, साथ ही इससे जुड़े सभी आउटपुट नोड्स के साथ, परिणाम अभी भी पूर्ण स्तंभ रैंक के साथ कनेक्टिविटी आव्युह द्वारा विशेषता होना चाहिए।

- पूरी पंक्ति रैंक होनी चाहिए।

तब अपघटन अदिश द्वारा गुणन तक अद्वितीय होता है।[88]

प्रमुख अवयवों का विभेदक विश्लेषण

प्रमुख कंपोनेंट्स (DAPC) का डिस्क्रिमिनेंट विश्लेषण बहुभिन्नरूपी विधि है जिसका उपयोग आनुवंशिक रूप से संबंधित व्यक्तियों के समूहों की पहचान करने और उनका वर्णन करने के लिए किया जाता है। आनुवंशिक भिन्नता को दो अवयवों में विभाजित किया गया है: समूहों के बीच और समूहों के भीतर भिन्नता, और यह पूर्व को अधिकतम करती है। रेखीय विभेदक युग्मविकल्पी के रेखीय संयोजन होते हैं जो गुच्छों को सर्वोत्तम रूप से भिन्न करते हैं। एलील्स जो इस भेदभाव में सबसे अधिक योगदान करते हैं, इसलिए वे हैं जो समूहों में सबसे अधिक स्पष्ट रूप से भिन्न हैं। डीएपीसी द्वारा पहचाने गए समूहों में एलील्स का योगदान समूहों के बीच आनुवंशिक विचलन को चलाने वाले जीनोम के क्षेत्रों की पहचान करने की अनुमति दे सकता है।[89] DAPC में, डेटा को पहले प्रमुख अवयव विश्लेषण (पीसीए ) का उपयोग करके रूपांतरित किया जाता है और पश्चात में विभेदक विश्लेषण (DA) का उपयोग करके समूहों की पहचान की जाती है।

Adegenet पैकेज का उपयोग करके R पर DAPC प्राप्त किया जा सकता है। (अधिक जानकारी: adegenet वेब पर)

दिशात्मक अवयव विश्लेषण

दिशात्मक अवयव विश्लेषण (DCA) बहुभिन्नरूपी डेटासमुच्चय के विश्लेषण के लिए वायुमंडलीय विज्ञान में उपयोग की जाने वाली विधि है।[90]पीसीए की तरह, यह आयाम में कमी, बेहतर विज़ुअलाइज़ेशन और बड़े डेटा-समुच्चय की बेहतर व्याख्या करने की अनुमति देता है। पीसीए की तरह, यह इनपुट डेटासमुच्चय से प्राप्त सहप्रसरण आव्युह पर आधारित है। पीसीए और डीसीए के बीच अंतर यह है कि डीसीए को सदिश दिशा के इनपुट की अतिरिक्त आवश्यकता होती है, जिसे प्रभाव कहा जाता है। जबकि पीसीए स्पष्ट विचरण को अधिकतम करता है, डीसीए प्रभाव को देखते हुए संभाव्यता घनत्व को अधिकतम करता है। DCA के लिए प्रेरणा बहुभिन्नरूपी डेटासमुच्चय के अवयवों को खोजना है जो संभावित (संभाव्यता घनत्व का उपयोग करके मापा गया) और महत्वपूर्ण (प्रभाव का उपयोग करके मापा गया) दोनों हैं। DCA का उपयोग मौसम पूर्वानुमान समूहों में सबसे संभावित और सबसे गंभीर हीट-वेव पैटर्न खोजने के लिए किया गया है ,[91]और जलवायु परिवर्तन के कारण वर्षा में सबसे संभावित और सबसे प्रभावशाली परिवर्तन .[92]

सॉफ्टवेयर/स्रोत कोड

- ALGLIB - C++ और C# लाइब्रेरी जो पीसीए को लागू करती है और पीसीए को छोटा करती है

- एनालिटिका (सॉफ्टवेयर) - बिल्ट-इन EigenDecomp फ़ंक्शन प्रमुख अवयवों की गणना करता है।

- ईएलकेआई - प्रक्षेपण के लिए पीसीए सम्मिलित है, जिसमें पीसीए के मजबूत वेरिएंट, साथ ही पीसीए-आधारित क्लस्टर विश्लेषण सम्मिलित हैं।

- ग्रेटल - प्रमुख अवयव विश्लेषण या तो के माध्यम से किया जा सकता है

pcaकमांड या के माध्यम सेprincomp()समारोह। - जूलिया भाषा - के साथ पीसीए का समर्थन करता है

pcaMultivariateStats पैकेज में कार्य करता है - KNIME - विश्लेषण के लिए जावा आधारित नोडल व्यवस्था सॉफ्टवेयर, इसमें पीसीए, पीसीए कंप्यूट, पीसीए अप्लाई, पीसीए इनवर्स नामक नोड्स इसे आसानी से बनाते हैं।

- मेपल (सॉफ्टवेयर) - पीसीए कमांड का उपयोग डेटा के समुच्चय पर प्रमुख अवयव विश्लेषण करने के लिए किया जाता है।

- मेथेमेटिका - सहप्रसरण और सहसंबंध विधियों दोनों का उपयोग करके प्रमुख कंपोनेंट्स कमांड के साथ प्रमुख कंपोनेंट विश्लेषण लागू करता है।

- MathPHP - पीसीए के समर्थन के साथ पीएचपी गणित पुस्तकालय।

- MATLAB - एसवीडी फ़ंक्शन मूल प्रणाली का हिस्सा है। सांख्यिकी टूलबॉक्स में, कार्य

princompऔरpca(R2012b) प्रमुख अवयव देते हैं, जबकि कार्यpcaresनिम्न-रैंक पीसीए सन्निकटन के लिए अवशिष्ट और पुनर्निर्मित आव्युह देता है। - Matplotlib – Python (प्रोग्रामिंग लैंग्वेज) लाइब्रेरी में .mlab मॉड्यूल में पीसीए पैकेज है।

- mypack - सी ++ में प्रमुख अवयव विश्लेषण का कार्यान्वयन प्रदान करता है।

- mrmath - डेल्फी (सॉफ्टवेयर) और फ़्री पास्कल के लिए उच्च प्रदर्शन गणित पुस्तकालय पीसीए कर सकता है; मजबूत वेरिएंट सहित।

- एनएजी न्यूमेरिकल लाइब्रेरी - प्रधान अवयव विश्लेषण के माध्यम से कार्यान्वित किया जाता है

g03aaदिनवेरिएबल ्या (पुस्तकालय के दोनों फोरट्रान संस्करणों में उपलब्ध)। - NMath - .NET फ्रेमवर्क के लिए पीसीए युक्त मालिकाना संख्यात्मक पुस्तकालय।

- जीएनयू ऑक्टेव - मुफ्त सॉफ्टवेयर कम्प्यूटेशनल वातावरण ज्यादातर MATLAB, फ़ंक्शन के साथ संगत है

princompप्रमुख अवयव देता है। - ओपनसीवी

- Oracle डाटाबेस 12c - के माध्यम से लागू किया गया

DBMS_DATA_MINING.SVDS_SCORING_MODEसमुच्चय िंग मान निर्दिष्ट करकेSVDS_SCORING_पीसीए - ऑरेंज (सॉफ्टवेयर) - अपने दृश्य प्रोग्रामिंग वातावरण में पीसीए को एकीकृत करता है। पीसीए स्क्री प्लॉट (व्याख्या विचरण की डिग्री) प्रदर्शित करता है जहां उपयोगकर्ता प्रमुख अवयवों की संख्या को अंतःक्रियात्मक रूप से चुन सकता है।

- उत्पत्ति (डेटा विश्लेषण सॉफ्टवेयर) - इसके प्रो संस्करण में पीसीए सम्मिलित है।

- क्लोकोर - पीसीए का उपयोग करके त्वरित प्रतिक्रिया के साथ बहुभिन्नरूपी डेटा का विश्लेषण करने के लिए वाणिज्यिक सॉफ्टवेयर।

- आर (प्रोग्रामिंग भाषा) - मुफ्त सॉफ्टवेयर सांख्यिकीय पैकेज, कार्य

princompऔरprcompप्रमुख अवयव विश्लेषण के लिए उपयोग किया जा सकता है;prcompएकवचन मूल्य अपघटन का उपयोग करता है जो आम तौर पर बेहतर संख्यात्मक सटीकता देता है। आर में पीसीए को लागू करने वाले कुछ पैकेजों में सम्मिलित हैं, लेकिन इन तक सीमित नहीं हैं:ade4,vegan,ExPosition,dimRed, औरFactoMineR. - एसएएस (सॉफ्टवेयर) - मालिकाना सॉफ्टवेयर; उदाहरण के लिए देखें[93]

- scikit-सीखें - मशीन लर्निंग के लिए पायथन लाइब्रेरी जिसमें अपघटन मॉड्यूल में पीसीए, प्रोबेबिलिस्टिक पीसीए, कर्नेल पीसीए, स्पार्स पीसीए और अन्य तकनीकें सम्मिलित हैं।

- साइलैब - फ्री और ओपन-सोर्स, क्रॉस-प्लेटफॉर्म न्यूमेरिकल कम्प्यूटेशनल पैकेज, फंक्शन

princompप्रमुख अवयव विश्लेषण, फ़ंक्शन की गणना करता हैpcaमानकीकृत वेरिएबल ों के साथ प्रमुख अवयव विश्लेषण की गणना करता है। - एसपीएसएस - पीसीए, कारक विश्लेषण और संबंधित क्लस्टर विश्लेषण के लिए सामाजिक वैज्ञानिकों द्वारा सामान्यतः उपयोग किया जाने वाला मालिकाना सॉफ्टवेयर।

- वीका (मशीन लर्निंग) - मशीन लर्निंग के लिए जावा लाइब्रेरी जिसमें प्रमुख अवयवों की गणना के लिए मॉड्यूल होते हैं।

यह भी देखें

- पत्राचार विश्लेषण (आकस्मिक तालिकाओं के लिए)

- एकाधिक पत्राचार विश्लेषण (गुणात्मक चर के लिए)

- मिश्रित डेटा का कारक विश्लेषण (मात्रात्मक और गुणात्मक चर के लिए)

- कैननिकल सहसंबंध

- CUR मैट्रिक्स सन्निकटन (निम्न-रैंक SVD सन्निकटन की जगह ले सकता है)

- Detrended पत्राचार विश्लेषण

- दिशात्मक घटक विश्लेषण

- गतिशील मोड अपघटन

- खुद का चेहरा

- अपेक्षा-अधिकतमकरण एल्गोरिथम

- v: अन्वेषी कारक विश्लेषण (विकिविश्वविद्यालय)

- क्रमगुणित कोड

- कार्यात्मक प्रमुख घटक विश्लेषण

- ज्यामितीय डेटा विश्लेषण

- स्वतंत्र घटक विश्लेषण

- कर्नेल पीसीए

- एल1-मानक प्रमुख घटक विश्लेषण

- निम्न-श्रेणी सन्निकटन

- मैट्रिक्स अपघटन

- गैर-नकारात्मक मैट्रिक्स गुणनखंड

- गैर रेखीय आयामीता में कमी

- ओजा का शासन

- बिंदु वितरण मॉडल (पीसीए मॉर्फोमेट्री और कंप्यूटर विजन पर लागू होता है)

- बी: सांख्यिकी/बहुभिन्नरूपी डेटा विश्लेषण/प्रमुख घटक विश्लेषण (विकिपुस्तक)

- प्रधान घटक प्रतिगमन

- एकवचन स्पेक्ट्रम विश्लेषण

- विलक्षण मान अपघटन

- विरल पीसीए

- रूपांतरण कोडिंग

- कम से कम वर्ग भारित

संदर्भ

- ↑ Jolliffe, Ian T.; Cadima, Jorge (2016-04-13). "Principal component analysis: a review and recent developments". Philosophical Transactions of the Royal Society A: Mathematical, Physical and Engineering Sciences. 374 (2065): 20150202. doi:10.1098/rsta.2015.0202. PMC 4792409. PMID 26953178.

- ↑ Barnett, T. P. & R. Preisendorfer. (1987). "कैनोनिकल सहसंबंध विश्लेषण द्वारा निर्धारित संयुक्त राज्य सतह हवा के तापमान के लिए मासिक और मौसमी पूर्वानुमान कौशल की उत्पत्ति और स्तर". Monthly Weather Review. 115 (9): 1825. Bibcode:1987MWRv..115.1825B. doi:10.1175/1520-0493(1987)115<1825:oaloma>2.0.co;2.

- ↑ Hsu, Daniel; Kakade, Sham M.; Zhang, Tong (2008). छिपे हुए मार्कोव मॉडल सीखने के लिए एक स्पेक्ट्रल एल्गोरिदम. arXiv:0811.4413. Bibcode:2008arXiv0811.4413H.

- ↑ 4.0 4.1 Markopoulos, Panos P.; Kundu, Sandipan; Chamadia, Shubham; Pados, Dimitris A. (15 August 2017). "बिट फ़्लिपिंग के माध्यम से कुशल एल1-नॉर्म प्रिंसिपल-कंपोनेंट विश्लेषण". IEEE Transactions on Signal Processing. 65 (16): 4252–4264. arXiv:1610.01959. Bibcode:2017ITSP...65.4252M. doi:10.1109/TSP.2017.2708023. S2CID 7931130.

- ↑ 5.0 5.1 Chachlakis, Dimitris G.; Prater-Bennette, Ashley; Markopoulos, Panos P. (22 November 2019). "एल1-मानदंड टकर टेन्सर अपघटन". IEEE Access. 7: 178454–178465. arXiv:1904.06455. doi:10.1109/ACCESS.2019.2955134.

- ↑ 6.0 6.1 Markopoulos, Panos P.; Karystinos, George N.; Pados, Dimitris A. (October 2014). "एल1-सबस्पेस सिग्नल प्रोसेसिंग के लिए इष्टतम एल्गोरिदम". IEEE Transactions on Signal Processing. 62 (19): 5046–5058. arXiv:1405.6785. Bibcode:2014ITSP...62.5046M. doi:10.1109/TSP.2014.2338077. S2CID 1494171.

- ↑ Zhan, J.; Vaswani, N. (2015). "आंशिक सबस्पेस ज्ञान के साथ मजबूत पीसीए". IEEE Transactions on Signal Processing. 63 (13): 3332–3347. arXiv:1403.1591. Bibcode:2015ITSP...63.3332Z. doi:10.1109/tsp.2015.2421485. S2CID 1516440.

- ↑ Kanade, T.; Ke, Qifa (June 2005). वैकल्पिक उत्तल प्रोग्रामिंग द्वारा बाहरी तत्वों की उपस्थिति और अनुपलब्ध डेटा में मजबूत L1 मानक गुणनखंडन. p. 739. CiteSeerX 10.1.1.63.4605. doi:10.1109/CVPR.2005.309. ISBN 978-0-7695-2372-9. S2CID 17144854.

{{cite book}}:|journal=ignored (help) - ↑ Pearson, K. (1901). "अंतरिक्ष में बिंदुओं के सिस्टम के निकटतम फिट की रेखाओं और विमानों पर". Philosophical Magazine. 2 (11): 559–572. doi:10.1080/14786440109462720.

- ↑ Hotelling, H. (1933). Analysis of a complex of statistical variables into principal components. Journal of Educational Psychology, 24, 417–441, and 498–520.

Hotelling, H (1936). "Relations between two sets of variates". Biometrika. 28 (3/4): 321–377. doi:10.2307/2333955. JSTOR 2333955. - ↑ Stewart, G. W. (1993). "On the early history of the singular value decomposition". SIAM Review. 35 (4): 551–566. doi:10.1137/1035134.

- ↑ 12.0 12.1 12.2 12.3 12.4 Jolliffe, I. T. (2002). प्रमुख कंपोनेंट विश्लेषण. Springer Series in Statistics (in English). New York: Springer-Verlag. doi:10.1007/b98835. ISBN 978-0-387-95442-4.

- ↑ Bengio, Y.; et al. (2013). "Representation Learning: A Review and New Perspectives". IEEE Transactions on Pattern Analysis and Machine Intelligence. 35 (8): 1798–1828. arXiv:1206.5538. doi:10.1109/TPAMI.2013.50. PMID 23787338. S2CID 393948.

- ↑ Forkman J., Josse, J., Piepho, H. P. (2019). "प्रमुख घटक विश्लेषण के लिए परिकल्पना परीक्षण जब चर मानकीकृत होते हैं". Journal of Agricultural, Biological, and Environmental Statistics. 24 (2): 289–308. doi:10.1007/s13253-019-00355-5.

{{cite journal}}: CS1 maint: multiple names: authors list (link) - ↑ A. A. Miranda, Y. A. Le Borgne, and G. Bontempi. New Routes from Minimal Approximation Error to Principal Components, Volume 27, Number 3 / June, 2008, Neural Processing Letters, Springer

- ↑ Fukunaga, Keinosuke (1990). सांख्यिकीय पैटर्न पहचान का परिचय. Elsevier. ISBN 978-0-12-269851-4.

- ↑ Alizadeh, Elaheh; Lyons, Samanthe M; Castle, Jordan M; Prasad, Ashok (2016). "Zernike मोमेंट्स का उपयोग करके आक्रामक कैंसर सेल आकार में व्यवस्थित परिवर्तनों को मापना". Integrative Biology. 8 (11): 1183–1193. doi:10.1039/C6IB00100A. PMID 27735002.

- ↑ Leznik, M; Tofallis, C. 2005 Estimating Invariant Principal Components Using Diagonal Regression.

- ↑ Jonathon Shlens, A Tutorial on Principal Component Analysis.

- ↑ 20.0 20.1 20.2 Soummer, Rémi; Pueyo, Laurent; Larkin, James (2012). "Detection and Characterization of Exoplanets and Disks Using Projections on Karhunen-Loève Eigenimages". The Astrophysical Journal Letters. 755 (2): L28. arXiv:1207.4197. Bibcode:2012ApJ...755L..28S. doi:10.1088/2041-8205/755/2/L28. S2CID 51088743.

- ↑ Pueyo, Laurent (2016). "Detection and Characterization of Exoplanets using Projections on Karhunen Loeve Eigenimages: Forward Modeling". The Astrophysical Journal. 824 (2): 117. arXiv:1604.06097. Bibcode:2016ApJ...824..117P. doi:10.3847/0004-637X/824/2/117. S2CID 118349503.

- ↑ 22.0 22.1 Blanton, Michael R.; Roweis, Sam (2007). "के-सुधार और पराबैंगनी, ऑप्टिकल और निकट अवरक्त में परिवर्तन". The Astronomical Journal. 133 (2): 734–754. arXiv:astro-ph/0606170. Bibcode:2007AJ....133..734B. doi:10.1086/510127. S2CID 18561804.

- ↑ 23.0 23.1 23.2 Zhu, Guangtun B. (2016-12-19). "गैर-ऋणात्मक मैट्रिक्स गुणनखंडन (NMF) विषमलैंगिक अनिश्चितताओं और लापता डेटा के साथ". arXiv:1612.06037 [astro-ph.IM].

- ↑ 24.0 24.1 24.2 24.3 24.4 24.5 Ren, Bin; Pueyo, Laurent; Zhu, Guangtun B.; Duchêne, Gaspard (2018). "Non-negative Matrix Factorization: Robust Extraction of Extended Structures". The Astrophysical Journal. 852 (2): 104. arXiv:1712.10317. Bibcode:2018ApJ...852..104R. doi:10.3847/1538-4357/aaa1f2. S2CID 3966513.

- ↑ "What are the Pros and cons of the PCA?". i2tutorials. September 1, 2019. Retrieved June 4, 2021.

- ↑ Abbott, Dean (May 2014). एप्लाइड प्रिडिक्टिव एनालिटिक्स. Wiley. ISBN 9781118727966.

- ↑ 27.0 27.1 Jiang, Hong; Eskridge, Kent M. (2000). "सहसंबद्ध प्रेक्षणों के कारण प्रधान घटक विश्लेषण में पक्षपात". Conference on Applied Statistics in Agriculture. doi:10.4148/2475-7772.1247. ISSN 2475-7772.

- ↑ Linsker, Ralph (March 1988). "एक अवधारणात्मक नेटवर्क में स्व-संगठन". IEEE Computer. 21 (3): 105–117. doi:10.1109/2.36. S2CID 1527671.

- ↑ Deco & Obradovic (1996). तंत्रिका कम्प्यूटिंग के लिए एक सूचना-सैद्धांतिक दृष्टिकोण. New York, NY: Springer. ISBN 9781461240167.

- ↑ Plumbley, Mark (1991). सूचना सिद्धांत और अनुपयोगी तंत्रिका नेटवर्क.Tech Note

- ↑ Geiger, Bernhard; Kubin, Gernot (January 2013). "प्रासंगिक सूचना हानि को कम करने के रूप में सिग्नल वृद्धि". Proc. ITG Conf. On Systems, Communication and Coding. arXiv:1205.6935. Bibcode:2012arXiv1205.6935G.

- ↑ "Engineering Statistics Handbook Section 6.5.5.2". Retrieved 19 January 2015.

- ↑ A.A. Miranda, Y.-A. Le Borgne, and G. Bontempi. New Routes from Minimal Approximation Error to Principal Components, Volume 27, Number 3 / June, 2008, Neural Processing Letters, Springer

- ↑ Abdi. H. & Williams, L.J. (2010). "प्रमुख कंपोनेंट विश्लेषण". Wiley Interdisciplinary Reviews: Computational Statistics. 2 (4): 433–459. arXiv:1108.4372. doi:10.1002/wics.101. S2CID 122379222.

- ↑ "SAS/STAT(R) 9.3 User's Guide".

- ↑ eig function Matlab documentation

- ↑ "चेहरा पहचान प्रणाली-पीसीए आधारित". www.mathworks.com.

- ↑ Eigenvalues function Mathematica documentation

- ↑ Roweis, Sam. "EM Algorithms for PCA and SPCA." Advances in Neural Information Processing Systems. Ed. Michael I. Jordan, Michael J. Kearns, and Sara A. Solla The MIT Press, 1998.

- ↑ Geladi, Paul; Kowalski, Bruce (1986). "Partial Least Squares Regression:A Tutorial". Analytica Chimica Acta. 185: 1–17. doi:10.1016/0003-2670(86)80028-9.

- ↑ Kramer, R. (1998). मात्रात्मक विश्लेषण के लिए रसायनमितीय तकनीक. New York: CRC Press. ISBN 9780203909805.

- ↑ Andrecut, M. (2009). "इटरेटिव पीसीए एल्गोरिदम का समानांतर जीपीयू कार्यान्वयन". Journal of Computational Biology. 16 (11): 1593–1599. arXiv:0811.1081. doi:10.1089/cmb.2008.0221. PMID 19772385. S2CID 1362603.

- ↑ Warmuth, M. K.; Kuzmin, D. (2008). "Randomized online PCA algorithms with regret bounds that are logarithmic in the dimension" (PDF). Journal of Machine Learning Research. 9: 2287–2320.

- ↑ Kaplan, R.M., & Saccuzzo, D.P. (2010). Psychological Testing: Principles, Applications, and Issues. (8th ed.). Belmont, CA: Wadsworth, Cengage Learning.

- ↑ Shevky, Eshref; Williams, Marilyn (1949). The Social Areas of Los Angeles: Analysis and Typology. University of California Press.

- ↑ Flood, J (2000). Sydney divided: factorial ecology revisited. Paper to the APA Conference 2000, Melbourne,November and to the 24th ANZRSAI Conference, Hobart, December 2000.[1]

- ↑ "क्षेत्रों के लिए सामाजिक-आर्थिक सूचकांक". Australian Bureau of Statistics (in English). 2011. Retrieved 2022-05-05.

- ↑ Human Development Reports. "मानव विकास सूचकांक". United Nations Development Programme. Retrieved 2022-05-06.

- ↑ Novembre, John; Stephens, Matthew (2008). "स्थानिक जनसंख्या आनुवंशिक भिन्नता के प्रमुख घटक विश्लेषण की व्याख्या करना". Nat Genet. 40 (5): 646–49. doi:10.1038/ng.139. PMC 3989108. PMID 18425127.

- ↑ Elhaik, Eran (2022). "Principal Component Analyses (PCA)‑based findings in population genetic studies are highly biased and must be reevaluated". Scientific Reports. 12 (1). 14683. doi:10.1038/s41598-022-14395-4. PMC 9424212. PMID 36038559. S2CID 251932226.

- ↑ DeSarbo, Wayne; Hausmann, Robert; Kukitz, Jeffrey (2007). "विपणन अनुसंधान के लिए प्रतिबंधित प्रमुख घटक विश्लेषण". Journal of Marketing in Management. 2: 305–328 – via Researchgate.

- ↑ Dutton, William H; Blank, Grant (2013). Cultures of the Internet: The Internet in Britain (PDF). Oxford Internet Institute. p. 6.

- ↑ Flood, Joe (2008). "हाउसिंग करियर सर्वे के लिए बहुराष्ट्रीय विश्लेषण". Paper to the European Network for Housing Research Conference, Dublin. Retrieved 6 May 2022.

- ↑ The Pricing and Hedging of Interest Rate Derivatives: A Practical Guide to Swaps, J H M Darbyshire, 2016, ISBN 978-0995455511

- ↑ Giorgia Pasini (2017); Principal Component Analysis for Stock Portfolio Management. International Journal of Pure and Applied Mathematics. Volume 115 No. 1 2017, 153–167

- ↑ Libin Yang. An Application of Principal Component Analysis to Stock Portfolio Management. Department of Economics and Finance, University of Canterbury, January 2015.

- ↑ Chapin, John; Nicolelis, Miguel (1999). "न्यूरोनल पहनावा गतिविधि के प्रधान घटक विश्लेषण से बहुआयामी सोमाटोसेंसरी अभ्यावेदन का पता चलता है". Journal of Neuroscience Methods. 94 (1): 121–140. doi:10.1016/S0165-0270(99)00130-2. PMID 10638820.

- ↑ Brenner, N., Bialek, W., & de Ruyter van Steveninck, R.R. (2000).

- ↑ Jirsa, Victor; Friedrich, R; Haken, Herman; Kelso, Scott (1994). "मानव मस्तिष्क में चरण संक्रमण का एक सैद्धांतिक मॉडल". Biological Cybernetics. 71 (1): 27–35. doi:10.1007/bf00198909. PMID 8054384. S2CID 5155075.

- ↑ Benzécri, J.-P. (1973). L'Analyse des Données. Volume II. L'Analyse des Correspondances. Paris, France: Dunod.

- ↑ Greenacre, Michael (1983). Theory and Applications of Correspondence Analysis. London: Academic Press. ISBN 978-0-12-299050-2.

- ↑ Le Roux; Brigitte and Henry Rouanet (2004). Geometric Data Analysis, From Correspondence Analysis to Structured Data Analysis. Dordrecht: Kluwer. ISBN 9781402022357.

- ↑ Timothy A. Brown. Confirmatory Factor Analysis for Applied Research Methodology in the social sciences. Guilford Press, 2006

- ↑ Meglen, R.R. (1991). "Examining Large Databases: A Chemometric Approach Using Principal Component Analysis". Journal of Chemometrics. 5 (3): 163–179. doi:10.1002/cem.1180050305. S2CID 120886184.

- ↑ H. Zha; C. Ding; M. Gu; X. He; H.D. Simon (Dec 2001). "K- साधन क्लस्टरिंग के लिए वर्णक्रमीय विश्राम" (PDF). Neural Information Processing Systems Vol.14 (NIPS 2001): 1057–1064.

- ↑ Chris Ding; Xiaofeng He (July 2004). "K- साधन प्रमुख घटक विश्लेषण के माध्यम से क्लस्टरिंग" (PDF). Proc. Of Int'l Conf. Machine Learning (ICML 2004): 225–232.

- ↑ Drineas, P.; A. Frieze; R. Kannan; S. Vempala; V. Vinay (2004). "एकवचन मूल्य अपघटन के माध्यम से बड़े रेखांकन को क्लस्टर करना" (PDF). Machine Learning. 56 (1–3): 9–33. doi:10.1023/b:mach.0000033113.59016.96. S2CID 5892850. Retrieved 2012-08-02.

- ↑ Cohen, M.; S. Elder; C. Musco; C. Musco; M. Persu (2014). के-मीन्स क्लस्टरिंग और निम्न रैंक सन्निकटन के लिए आयाम में कमी (परिशिष्ट बी). arXiv:1410.6801. Bibcode:2014arXiv1410.6801C.

- ↑ Hui Zou; Trevor Hastie; Robert Tibshirani (2006). "Sparse principal component analysis" (PDF). Journal of Computational and Graphical Statistics. 15 (2): 262–286. CiteSeerX 10.1.1.62.580. doi:10.1198/106186006x113430. S2CID 5730904.

- ↑ Alexandre d'Aspremont; Laurent El Ghaoui; Michael I. Jordan; Gert R. G. Lanckriet (2007). "A Direct Formulation for Sparse PCA Using Semidefinite Programming" (PDF). SIAM Review. 49 (3): 434–448. arXiv:cs/0406021. doi:10.1137/050645506. S2CID 5490061.

- ↑ Michel Journee; Yurii Nesterov; Peter Richtarik; Rodolphe Sepulchre (2010). "Generalized Power Method for Sparse Principal Component Analysis" (PDF). Journal of Machine Learning Research. 11: 517–553. arXiv:0811.4724. Bibcode:2008arXiv0811.4724J. CORE Discussion Paper 2008/70.

- ↑ Peter Richtarik; Martin Takac; S. Damla Ahipasaoglu (2012). "Alternating Maximization: Unifying Framework for 8 Sparse PCA Formulations and Efficient Parallel Codes". arXiv:1212.4137 [stat.ML].

- ↑ Baback Moghaddam; Yair Weiss; Shai Avidan (2005). "Spectral Bounds for Sparse PCA: Exact and Greedy Algorithms" (PDF). Advances in Neural Information Processing Systems. Vol. 18. MIT Press.

- ↑ Yue Guan; Jennifer Dy (2009). "Sparse Probabilistic Principal Component Analysis" (PDF). Journal of Machine Learning Research Workshop and Conference Proceedings. 5: 185.

- ↑ Hui Zou; Lingzhou Xue (2018). "A Selective Overview of Sparse Principal Component Analysis". Proceedings of the IEEE. 106 (8): 1311–1320. doi:10.1109/JPROC.2018.2846588.

- ↑ A. N. Gorban, A. Y. Zinovyev, "Principal Graphs and Manifolds", In: Handbook of Research on Machine Learning Applications and Trends: Algorithms, Methods and Techniques, Olivas E.S. et al Eds. Information Science Reference, IGI Global: Hershey, PA, USA, 2009. 28–59.

- ↑ Wang, Y.; Klijn, J. G.; Zhang, Y.; Sieuwerts, A. M.; Look, M. P.; Yang, F.; Talantov, D.; Timmermans, M.; Meijer-van Gelder, M. E.; Yu, J.; et al. (2005). "लिम्फ-नोड-नकारात्मक प्राथमिक स्तन कैंसर के दूर के मेटास्टेसिस की भविष्यवाणी करने के लिए जीन अभिव्यक्ति प्रोफाइल". The Lancet. 365 (9460): 671–679. doi:10.1016/S0140-6736(05)17947-1. PMID 15721472. S2CID 16358549. Data online

- ↑ Zinovyev, A. "ViDaExpert – Multidimensional Data Visualization Tool". Institut Curie. Paris. (free for non-commercial use)

- ↑ Hastie, T.; Stuetzle, W. (June 1989). "प्रधान वक्र" (PDF). Journal of the American Statistical Association. 84 (406): 502–506. doi:10.1080/01621459.1989.10478797.

- ↑ A.N. Gorban, B. Kegl, D.C. Wunsch, A. Zinovyev (Eds.), Principal Manifolds for Data Visualisation and Dimension Reduction, LNCSE 58, Springer, Berlin – Heidelberg – New York, 2007. ISBN 978-3-540-73749-0

- ↑ Vasilescu, M.A.O.; Terzopoulos, D. (2003). Multilinear Subspace Analysis of Image Ensembles (PDF). Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR’03). Madison, WI.

- ↑ Vasilescu, M.A.O.; Terzopoulos, D. (2002). Multilinear Analysis of Image Ensembles: TensorFaces (PDF). Lecture Notes in Computer Science 2350; (Presented at Proc. 7th European Conference on Computer Vision (ECCV'02), Copenhagen, Denmark). Springer, Berlin, Heidelberg. doi:10.1007/3-540-47969-4_30. ISBN 978-3-540-43745-1.

- ↑ Vasilescu, M.A.O.; Terzopoulos, D. (June 2005). Multilinear Independent Component Analysis (PDF). Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR’05). Vol. 1. San Diego, CA. pp. 547–553.

- ↑ Kriegel, H. P.; Kröger, P.; Schubert, E.; Zimek, A. (2008). पीसीए-आधारित सहसंबंध क्लस्टरिंग एल्गोरिदम की मजबूती बढ़ाने के लिए एक सामान्य ढांचा. pp. 418–435. CiteSeerX 10.1.1.144.4864. doi:10.1007/978-3-540-69497-7_27. ISBN 978-3-540-69476-2.

{{cite book}}:|journal=ignored (help) - ↑ Emmanuel J. Candes; Xiaodong Li; Yi Ma; John Wright (2011). "Robust Principal Component Analysis?". Journal of the ACM. 58 (3): 11. arXiv:0912.3599. doi:10.1145/1970392.1970395. S2CID 7128002.