रैखिक विभेदक विश्लेषण

लीनियर डिस्क्रिमिनेंट एनालिसिस (LDA), नॉर्मल डिस्क्रिमिनेंट एनालिसिस (NDA), या डिस्क्रिमिनेंट फंक्शन एनालिसिस, फिशर के लीनियर डिस्क्रिमिनेंट का एक सामान्यीकरण है, जो सांख्यिकी और अन्य क्षेत्रों में उपयोग की जाने वाली एक विधि है, जो दो या दो से अधिक वर्गों को चिह्नित या अलग करने वाली विशेषताओं का एक रैखिक संयोजन खोजने के लिए है। वस्तुओं या घटनाओं का। परिणामी संयोजन का उपयोग एक रेखीय क्लासिफायरियर के रूप में किया जा सकता है, या बाद में सांख्यिकीय वर्गीकरण से पहले आयामीता में कमी के लिए अधिक सामान्यतः।

एलडीए विचरण (एनोवा) और प्रतिगमन विश्लेषण के विश्लेषण से निकटता से संबंधित है, जो एक आश्रित चर को अन्य विशेषताओं या मापों के रैखिक संयोजन के रूप में व्यक्त करने का प्रयास करता है।[1][2] हालाँकि, ANOVA श्रेणीबद्ध चर स्वतंत्र चर और एक सतत चर आश्रित चर का उपयोग करता है, जबकि विवेचक विश्लेषण में निरंतर स्वतंत्र चर और एक श्रेणीबद्ध आश्रित चर (अर्थात वर्ग लेबल) होता है।[3] लॉजिस्टिक प्रतिगमन और प्रोबिट प्रतिगमन एनोवा की तुलना में एलडीए के समान हैं, क्योंकि वे निरंतर स्वतंत्र चर के मूल्यों द्वारा एक श्रेणीगत चर की व्याख्या भी करते हैं। ये अन्य तरीके उन अनुप्रयोगों में बेहतर हैं जहां यह मान लेना उचित नहीं है कि स्वतंत्र चर सामान्य रूप से वितरित किए जाते हैं, जो एलडीए पद्धति की एक मौलिक धारणा है।

एलडीए प्रमुख कंपोनेंट विश्लेषण (पीसीए) और कारक विश्लेषण से भी निकटता से संबंधित है, जिसमें वे दोनों वेरिएबल्स के रैखिक संयोजनों की तलाश करते हैं जो डेटा की सबसे अच्छी व्याख्या करते हैं।[4] एलडीए स्पष्ट रूप से डेटा की कक्षाओं के बीच अंतर को मॉडल करने का प्रयास करता है। पीसीए, इसके विपरीत, वर्ग में किसी भी अंतर को ध्यान में नहीं रखता है, और कारक विश्लेषण समानता के बजाय अंतर के आधार पर फीचर संयोजन बनाता है। विभेदक विश्लेषण भी कारक विश्लेषण से अलग है क्योंकि यह एक अन्योन्याश्रित तकनीक नहीं है: स्वतंत्र चर और निर्भर चर (जिसे कसौटी चर भी कहा जाता है) के बीच एक अंतर बनाया जाना चाहिए।

एलडीए काम करता है जब प्रत्येक अवलोकन के लिए स्वतंत्र चर पर किए गए माप निरंतर मात्रा होते हैं। स्पष्ट स्वतंत्र चर के साथ व्यवहार करते समय, समतुल्य तकनीक विवेकशील पत्राचार विश्लेषण है।[5][6] भेदभावपूर्ण विश्लेषण का उपयोग तब किया जाता है जब समूहों को प्राथमिकता (क्लस्टर विश्लेषण के विपरीत) जाना जाता है। प्रत्येक मामले में एक या अधिक मात्रात्मक भविष्यवक्ता उपायों पर एक अंक और एक समूह माप पर एक अंक होना चाहिए।[7] सरल शब्दों में, विभेदक कार्य विश्लेषण वर्गीकरण है - चीजों को समूहों, वर्गों या समान प्रकार की श्रेणियों में वितरित करने का कार्य।

इतिहास

1936 में सर रोनाल्ड फिशर द्वारा मूल द्विभाजन विभेदक विश्लेषण विकसित किया गया था।[8] यह एक एनोवा या परिवर्तन से अलग है, जिसका उपयोग एक या एक से अधिक स्वतंत्र श्रेणीबद्ध चर द्वारा एक (एनोवा) या एकाधिक (मैनोवा) निरंतर आश्रित चर की भविष्यवाणी करने के लिए किया जाता है। भेदभावपूर्ण कार्य विश्लेषण यह निर्धारित करने में उपयोगी है कि श्रेणी सदस्यता की भविष्यवाणी करने में चर का एक सेट प्रभावी है या नहीं।[9]

दो वर्गों के लिए एलडीए

टिप्पणियों के एक सेट पर विचार करें ज्ञात वर्ग के साथ किसी वस्तु या घटना के प्रत्येक नमूने के लिए (जिसे विशेषताएं, विशेषताएँ, चर या माप भी कहा जाता है)। . नमूनों के इस सेट को प्रशिक्षण सेट कहा जाता है। वर्गीकरण समस्या तब वर्ग के लिए एक अच्छा भविष्यवक्ता खोजने की है एक ही वितरण के किसी भी नमूने का (जरूरी नहीं कि प्रशिक्षण सेट से) केवल एक अवलोकन दिया गया हो .[10]: 338

एलडीए सशर्त संभाव्यता घनत्व कार्यों को मानकर समस्या का समाधान करता है और माध्य और सहप्रसरण मापदंडों के साथ दोनों बहुभिन्नरूपी सामान्य वितरण हैं और , क्रमश। इस धारणा के तहत, बेयस वर्गीकारक | बेयस-इष्टतम समाधान अंक को दूसरी श्रेणी से होने की भविष्यवाणी करना है यदि संभावना अनुपात का लॉग कुछ थ्रेशोल्ड टी से बड़ा है, ताकि:

किसी और धारणा के बिना, परिणामी वर्गीकारक को द्विघात वर्गीकारक (QDA) के रूप में संदर्भित किया जाता है।

एलडीए इसके बजाय अतिरिक्त सरलीकृत समरूपता धारणा बनाता है (अर्थात कि वर्ग सहप्रसरण समान हैं, इसलिए ) और यह कि सहप्रसरण की पूरी रैंक है। इस मामले में, कई शर्तें रद्द:

- क्योंकि हर्मिटियन मैट्रिक्स है

और उपरोक्त निर्णय मानदंड डॉट उत्पाद पर दहलीज बन जाता है

कुछ दहलीज स्थिर सी के लिए, जहां

इसका मतलब है कि एक इनपुट की कसौटी एक कक्षा में होना विशुद्ध रूप से ज्ञात प्रेक्षणों के इस रैखिक संयोजन का फलन है।

इस निष्कर्ष को ज्यामितीय दृष्टि से देखना अक्सर उपयोगी होता है: एक इनपुट की कसौटी एक कक्षा में होना विशुद्ध रूप से बहुआयामी-अंतरिक्ष बिंदु के प्रक्षेपण का कार्य है वेक्टर पर (इस प्रकार, हम केवल इसकी दिशा पर विचार करते हैं)। दूसरे शब्दों में, अवलोकन का है यदि संगत है के लंबवत हाइपरप्लेन के एक निश्चित तरफ स्थित है . विमान का स्थान दहलीज द्वारा परिभाषित किया गया है .

अनुमान

विवेचक विश्लेषण की धारणाएं मनोवा के समान ही हैं। विश्लेषण आउटलेयर के प्रति काफी संवेदनशील है और सबसे छोटे समूह का आकार पूर्वसूचक चर की संख्या से बड़ा होना चाहिए।[7]

- बहुभिन्नरूपी सामान्य वितरण: समूहीकरण चर के प्रत्येक स्तर के लिए स्वतंत्र चर सामान्य होते हैं।[9][7]*प्रसरण/सहप्रसरण की एकरूपता (समरूपता): समूह चरों के बीच भिन्नताएँ भविष्यवक्ताओं के स्तरों पर समान होती हैं। बॉक्स के एम परीक्षण के साथ परीक्षण किया जा सकता है | बॉक्स के एम आंकड़े।[9]हालांकि, यह सुझाव दिया गया है कि सहप्रसरण समान होने पर रैखिक विभेदक विश्लेषण का उपयोग किया जाता है, और जब सहप्रसरण समान नहीं होते हैं तो द्विघात क्लासिफायर #क्वाड्रैटिक विवेचक विश्लेषण का उपयोग किया जा सकता है।[7]*बहुसंरेखता: पूर्वसूचक चरों के बीच बढ़े हुए सहसंबंध के साथ भविष्य कहनेवाला शक्ति घट सकती है।[7]*सांख्यिकीय स्वतंत्रता: प्रतिभागियों को यादृच्छिक नमूना माना जाता है, और एक चर पर एक प्रतिभागी का स्कोर अन्य सभी प्रतिभागियों के लिए उस चर पर स्कोर से स्वतंत्र माना जाता है।[9][7]

यह सुझाव दिया गया है कि भेदभावपूर्ण विश्लेषण इन मान्यताओं के मामूली उल्लंघनों के लिए अपेक्षाकृत मजबूत है,[11] और यह भी दिखाया गया है कि द्विबीजपत्री चर (जहां बहुभिन्नरूपी सामान्यता का अक्सर उल्लंघन किया जाता है) का उपयोग करते समय विभेदक विश्लेषण अभी भी विश्वसनीय हो सकता है।[12]

भेदभावपूर्ण कार्य

विवेकशील विश्लेषण भविष्यवक्ताओं के एक या अधिक रैखिक संयोजन बनाकर काम करता है, प्रत्येक फ़ंक्शन के लिए एक नया अव्यक्त चर बनाता है। इन कार्यों को विभेदक कार्य कहा जाता है। संभव कार्यों की संख्या या तो है कहाँ = समूहों की संख्या, या (भविष्यवाणियों की संख्या), जो भी छोटा हो। बनाया गया पहला फ़ंक्शन उस फ़ंक्शन पर समूहों के बीच अंतर को अधिकतम करता है। दूसरा फ़ंक्शन उस फ़ंक्शन पर अंतर को अधिकतम करता है, लेकिन पिछले फ़ंक्शन के साथ सहसंबद्ध भी नहीं होना चाहिए। यह बाद के कार्यों के साथ इस आवश्यकता के साथ जारी रहता है कि नया कार्य पिछले कार्यों में से किसी के साथ सहसंबद्ध न हो।

दिया गया समूह , साथ नमूना स्थान के सेट, एक भेदभावपूर्ण नियम है जैसे कि यदि , तब . भेदभावपूर्ण विश्लेषण तब, के "भोजन" क्षेत्रों को खोजें वर्गीकरण त्रुटि को कम करने के लिए, इसलिए वर्गीकरण तालिका में उच्च प्रतिशत सही वर्गीकृत करने के लिए अग्रणी।[13] प्रत्येक फ़ंक्शन को एक विवेकशील स्कोर दिया जाता है[clarification needed] यह निर्धारित करने के लिए कि यह समूह प्लेसमेंट की कितनी अच्छी भविष्यवाणी करता है।

- संरचना सहसंबंध गुणांक: प्रत्येक भविष्यवक्ता और प्रत्येक कार्य के विवेचक स्कोर के बीच सहसंबंध। यह एक शून्य-क्रम सहसंबंध है (अर्थात, अन्य भविष्यवक्ताओं के लिए सही नहीं)।[14]

- मानकीकृत गुणांक: रैखिक संयोजन में प्रत्येक भविष्यवक्ता का वजन जो कि विभेदक कार्य है। एक प्रतिगमन समीकरण की तरह, ये गुणांक आंशिक हैं (यानी, अन्य भविष्यवक्ताओं के लिए सही)। समूह असाइनमेंट की भविष्यवाणी करने में प्रत्येक भविष्यवक्ता के अद्वितीय योगदान को इंगित करता है।

- ग्रुप सेंट्रोइड्स पर कार्य: प्रत्येक ग्रुपिंग वेरिएबल के लिए मीन डिस्क्रिमिनेंट स्कोर प्रत्येक फंक्शन के लिए दिए गए हैं। साधन जितने दूर होंगे, वर्गीकरण में उतनी ही कम त्रुटि होगी।

भेदभाव नियम

- अधिकतम संभावना: असाइन करें उस समूह के लिए जो जनसंख्या (समूह) घनत्व को अधिकतम करता है।[15]

- बेयस डिस्क्रिमिनेंट रूल: असाइन करता है अधिकतम करने वाले समूह के लिए , जहां पiउस वर्गीकरण की पूर्व संभावना का प्रतिनिधित्व करता है, और जनसंख्या घनत्व का प्रतिनिधित्व करता है।[15]*#फिशर का रेखीय विविक्तकर|फिशर का रेखीय विविक्तकर नियम: एसएस के बीच अनुपात को अधिकतम करता हैbetween और एस.एसwithin, और समूह की भविष्यवाणी करने के लिए भविष्यवक्ताओं का एक रैखिक संयोजन पाता है।[15]

ईजेनवेल्यूज

विवेचक विश्लेषण में आइगेनवैल्यू और ईजेनवेक्टर प्रत्येक फ़ंक्शन की विशेषता जड़ हैं।[clarification needed] यह इस बात का संकेत है कि वह कार्य समूहों को कितनी अच्छी तरह से अलग करता है, जहां ईगेनवैल्यू जितना बड़ा होता है, उतना ही बेहतर कार्य अलग करता है।[7]हालाँकि, इसे सावधानी के साथ समझा जाना चाहिए, क्योंकि आइगेनवैल्यूज़ की कोई ऊपरी सीमा नहीं है।[9][7] eigenvalue को SS के अनुपात के रूप में देखा जा सकता हैbetween और एस.एसwithin एनोवा के रूप में जब आश्रित चर विवेचक कार्य है, और समूह वाद्य चर के स्तर हैं[clarification needed].[9]इसका मतलब यह है कि सबसे बड़ा eigenvalue पहले फ़ंक्शन के साथ जुड़ा हुआ है, दूसरा सबसे बड़ा दूसरे के साथ, आदि।

प्रभाव आकार

कुछ सुझाव देते हैं कि प्रभाव आकार उपायों के रूप में eigenvalues का उपयोग किया जाता है, हालांकि, यह आम तौर पर समर्थित नहीं है।[9]इसके बजाय, विहित सहसंबंध प्रभाव आकार का पसंदीदा उपाय है। यह eigenvalue के समान है, लेकिन SS के अनुपात का वर्गमूल हैbetween और एस.एसtotal. यह समूहों और कार्यों के बीच संबंध है।[9] प्रभाव के आकार का एक अन्य लोकप्रिय माप प्रसरण का प्रतिशत है[clarification needed] प्रत्येक समारोह के लिए। इसकी गणना इस प्रकार की जाती है: (λx/ क्रमi) एक्स 100 जहां λxफ़ंक्शन और Σλ के लिए eigenvalue हैiसभी eigenvalues का योग है। यह हमें बताता है कि अन्य कार्यों की तुलना में उस विशेष कार्य के लिए भविष्यवाणी कितनी मजबूत है।[9] सही ढंग से वर्गीकृत प्रतिशत का प्रभाव आकार के रूप में भी विश्लेषण किया जा सकता है। कप्पा मूल्य इसका वर्णन मौका समझौते के लिए सुधार करते समय कर सकता है।[9]Kappa normalizes across all categorizes rather than biased by a significantly good or poorly performing classes.[clarification needed][16]

के वर्गों के लिए विहित विभेदक विश्लेषण

कैनोनिकल डिस्क्रिमिनेंट एनालिसिस (CDA) अक्षों (k − 1 कैनोनिकल निर्देशांक, k वर्गों की संख्या है) का पता लगाता है जो श्रेणियों को सबसे अच्छी तरह से अलग करता है। ये रैखिक कार्य असंबद्ध हैं और वास्तव में डेटा के एन-आयामी बादल के माध्यम से एक इष्टतम k − 1 स्थान परिभाषित करते हैं जो k समूहों (उस स्थान में अनुमानों) को सबसे अच्छी तरह से अलग करता है। नीचे विवरण के लिए "#Multiclass LDA" देखें।

फिशर का रैखिक विवेचक

फ़िशर के रैखिक विवेचक और LDA शब्द अक्सर एक दूसरे के स्थान पर उपयोग किए जाते हैं, हालांकि रोनाल्ड ए. फ़िशर|फ़िशर का मूल लेख[1]वास्तव में थोड़ा अलग भेदभाव का वर्णन करता है, जो एलडीए की कुछ धारणाओं को नहीं बनाता है जैसे कि सामान्य वितरण वर्ग या समान वर्ग सहप्रसरण।

मान लीजिए कि टिप्पणियों के दो वर्गों का मतलब है और सहप्रसरण . फिर सुविधाओं का रैखिक संयोजन साधन होंगे और प्रसरण के लिए . फिशर ने इन दो संभाव्यता वितरण के बीच अलगाव को वर्गों के बीच भिन्नता के वर्गों के बीच भिन्नता के अनुपात के रूप में परिभाषित किया:

यह उपाय, कुछ अर्थों में, क्लास लेबलिंग के लिए सिग्नल-टू-शोर अनुपात का एक उपाय है। यह दिखाया जा सकता है कि अधिकतम अलगाव कब होता है

जब एलडीए की धारणाएं संतुष्ट होती हैं, तो उपरोक्त समीकरण एलडीए के बराबर होता है।

ध्यान दें कि वेक्टर विवेचक hyperplane के लिए सतह सामान्य है। एक उदाहरण के रूप में, एक द्विविमीय समस्या में, वह रेखा जो दो समूहों को सर्वोत्तम रूप से विभाजित करती है, लम्बवत् होती है .

आम तौर पर, भेदभाव किए जाने वाले डेटा बिंदुओं पर अनुमान लगाया जाता है ; फिर एक आयामी वितरण के विश्लेषण से डेटा को सबसे अलग करने वाली सीमा को चुना जाता है। दहलीज के लिए कोई सामान्य नियम नहीं है। हालाँकि, यदि दोनों वर्गों के बिंदुओं का अनुमान लगभग समान वितरण प्रदर्शित करता है, तो एक अच्छा विकल्प दो साधनों के अनुमानों के बीच हाइपरप्लेन होगा, और . इस स्थिति में पैरामीटर c दहलीज स्थिति में है स्पष्ट रूप से पाया जा सकता है:

- .

ओत्सु की विधि फिशर के रेखीय विवेचक से संबंधित है, और एक ग्रेस्केल छवि में पिक्सेल के हिस्टोग्राम को बिनाराइज़ करने के लिए बनाया गया था, जो काले / सफेद थ्रेसहोल्ड को इष्टतम रूप से चुनकर इंट्रा-क्लास विचरण को कम करता है और ग्रेस्केल के भीतर / बीच अंतर-वर्ग विचरण को अधिकतम करता है। सफेद पिक्सेल वर्ग।

मल्टीक्लास एलडीए

ऐसे मामले में जहां दो से अधिक वर्ग हैं, फिशर विवेचक की व्युत्पत्ति में उपयोग किए गए विश्लेषण को एक रेखीय उप-स्थान खोजने के लिए विस्तारित किया जा सकता है जो कि सभी वर्ग परिवर्तनशीलता को समाहित करता प्रतीत होता है।[17] यह सामान्यीकरण सी. आर. राव के कारण है।[18] मान लीजिए कि प्रत्येक C वर्ग का माध्य है और वही सहप्रसरण . तब वर्ग परिवर्तनशीलता के बीच बिखराव को वर्ग माध्य के नमूना सहप्रसरण द्वारा परिभाषित किया जा सकता है

कहाँ वर्ग का माध्य है। एक दिशा में वर्ग जुदाई इस मामले में दिया जाएगा

इसका मतलब है कि जब का आइजन्वेक्टर है पृथक्करण संगत eigenvalue के बराबर होगा।

अगर विकर्णीय है, सुविधाओं के बीच परिवर्तनशीलता सी − 1 सबसे बड़े ईजेनवैल्यू के अनुरूप ईजेनवेक्टरों द्वारा फैलाए गए सबस्पेस में समाहित होगी (चूंकि अधिक से अधिक रैंक C − 1 का है)। ये ईजेनवेक्टर मुख्य रूप से पीसीए की तरह फीचर रिडक्शन में उपयोग किए जाते हैं। छोटे eigenvalues के अनुरूप eigenvectors प्रशिक्षण डेटा की सटीक पसंद के प्रति बहुत संवेदनशील होते हैं, और अगले खंड में वर्णित नियमितीकरण का उपयोग करना अक्सर आवश्यक होता है।

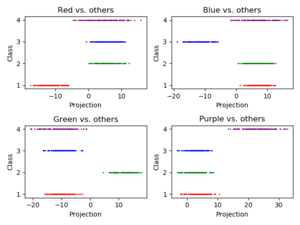

यदि वर्गीकरण की आवश्यकता है, तो आयाम में कमी के बजाय, कई वैकल्पिक तकनीकें उपलब्ध हैं। उदाहरण के लिए, वर्गों को विभाजित किया जा सकता है, और प्रत्येक विभाजन को वर्गीकृत करने के लिए एक मानक फिशर डिस्क्रिमिनेंट या LDA का उपयोग किया जाता है। इसका एक सामान्य उदाहरण बाकी के खिलाफ एक है जहां एक वर्ग के अंक एक समूह में रखे जाते हैं, और बाकी सब दूसरे में, और फिर एलडीए ने आवेदन किया। इसका परिणाम C क्लासिफायर होगा, जिसके परिणाम संयुक्त होंगे। एक और आम पद्धति जोड़ीवार वर्गीकरण है, जहां वर्गों के प्रत्येक जोड़े के लिए एक नया वर्गीकारक बनाया जाता है (कुल C(C − 1)/2 वर्गीकारक देकर), एक अंतिम वर्गीकरण तैयार करने के लिए अलग-अलग वर्गीकारकों के संयोजन के साथ।

इंक्रीमेंटल एलडीए

एलडीए तकनीक के विशिष्ट कार्यान्वयन के लिए आवश्यक है कि सभी नमूने पहले से उपलब्ध हों। हालाँकि, ऐसी स्थितियाँ होती हैं जहाँ संपूर्ण डेटा सेट उपलब्ध नहीं होता है और इनपुट डेटा को एक धारा के रूप में देखा जाता है। इस मामले में, एलडीए सुविधा निष्कर्षण के लिए यह वांछनीय है कि पूरे डेटा सेट पर एल्गोरिथ्म को चलाए बिना नए नमूनों को देखकर गणना की गई एलडीए सुविधाओं को अपडेट करने की क्षमता हो। उदाहरण के लिए, मोबाइल रोबोटिक्स या ऑन-लाइन फेस रिकग्निशन जैसे कई रीयल-टाइम अनुप्रयोगों में, जैसे ही नए अवलोकन उपलब्ध होते हैं, निकाले गए एलडीए सुविधाओं को अपडेट करना महत्वपूर्ण होता है। एक एलडीए सुविधा निष्कर्षण तकनीक जो केवल नए नमूनों को देखकर एलडीए सुविधाओं को अपडेट कर सकती है, एक वृद्धिशील एलडीए एल्गोरिथ्म है, और इस विचार का पिछले दो दशकों में बड़े पैमाने पर अध्ययन किया गया है।[19] चटर्जी और रॉयचौधरी ने एलडीए सुविधाओं को अद्यतन करने के लिए एक वृद्धिशील स्व-संगठित एलडीए एल्गोरिथम प्रस्तावित किया।[20] अन्य कार्य में, डेमिर और ओजमेमेट ने त्रुटि-सुधार और हेब्बियन सीखने के नियमों का उपयोग करते हुए एलडीए सुविधाओं को अद्यतन करने के लिए ऑनलाइन स्थानीय शिक्षण एल्गोरिदम प्रस्तावित किया।[21] बाद में, अलियारी एट अल। नए नमूने देखकर एलडीए सुविधाओं को अद्यतन करने के लिए तेजी से वृद्धिशील एल्गोरिदम व्युत्पन्न।[19]

व्यावहारिक उपयोग

व्यवहार में, वर्ग का अर्थ और सहप्रसरण ज्ञात नहीं हैं। हालाँकि, उनका अनुमान प्रशिक्षण सेट से लगाया जा सकता है। उपरोक्त समीकरणों में सटीक मान के स्थान पर या तो अधिकतम संभावना अनुमान या अधिकतम पश्च अनुमान का उपयोग किया जा सकता है। हालांकि सहप्रसरण के अनुमानों को कुछ अर्थों में इष्टतम माना जा सकता है, इसका मतलब यह नहीं है कि इन मूल्यों को प्रतिस्थापित करके प्राप्त परिणामी विवेचक किसी भी अर्थ में इष्टतम है, भले ही सामान्य रूप से वितरित वर्गों की धारणा सही हो।

एलडीए और फिशर के विवेचक को वास्तविक डेटा पर लागू करने में एक और जटिलता तब होती है जब प्रत्येक नमूने के माप की संख्या (यानी, प्रत्येक डेटा वेक्टर की आयाम) प्रत्येक वर्ग में नमूनों की संख्या से अधिक हो जाती है।[4]इस मामले में, सहप्रसरण अनुमानों की पूरी रैंक नहीं होती है, और इसलिए इसे उल्टा नहीं किया जा सकता है। इससे निपटने के कई तरीके हैं। उपरोक्त सूत्रों में सामान्य मैट्रिक्स व्युत्क्रम के बजाय छद्म व्युत्क्रम का उपयोग करना है। हालाँकि, बेहतर संख्यात्मक स्थिरता पहले समस्या को उप-स्थान पर पेश करके प्राप्त की जा सकती है .[22] छोटे नमूने के आकार से निपटने के लिए एक अन्य रणनीति सहप्रसरण मैट्रिक्स के संकोचन अनुमानक का उपयोग करना है, जो गणितीय रूप में व्यक्त किया जा सकता है

कहाँ पहचान मैट्रिक्स है, और संकोचन तीव्रता या नियमितीकरण पैरामीटर है। यह नियमित विभेदक विश्लेषण के ढांचे की ओर जाता है[23] या संकोचन विभेदक विश्लेषण।[24] साथ ही, कई व्यावहारिक मामलों में रैखिक विवेचक उपयुक्त नहीं होते हैं। एलडीए और फिशर के विवेचक को कर्नेल चाल के माध्यम से गैर-रैखिक वर्गीकरण में उपयोग के लिए बढ़ाया जा सकता है। यहां, मूल अवलोकन प्रभावी रूप से एक उच्च आयामी गैर-रैखिक स्थान में मैप किए जाते हैं। इस गैर-रैखिक स्थान में रैखिक वर्गीकरण तब मूल स्थान में गैर-रैखिक वर्गीकरण के बराबर होता है। इसका सबसे अधिक इस्तेमाल किया जाने वाला उदाहरण [[कर्नेल एकाधिक विभेदक विश्लेषण]] है।

एलडीए को कई विभेदक विश्लेषणों के लिए सामान्यीकृत किया जा सकता है, जहां सी केवल दो के बजाय एन संभावित राज्यों के साथ एक श्रेणीबद्ध चर बन जाता है। अनुरूप रूप से, यदि वर्ग-सशर्त घनत्व साझा सहप्रसरण के साथ सामान्य हैं, के लिए पर्याप्त आँकड़ा एन अनुमानों के मूल्य हैं, जो एन साधनों द्वारा फैलाए गए रैखिक उप-स्थान हैं, व्युत्क्रम सहप्रसरण मैट्रिक्स द्वारा परिशोधित परिवर्तन। इन अनुमानों को एक मैट्रिक्स#सामान्यीकृत ईजेनवैल्यू समस्या के ईजेनडीकंपोजीशन को हल करके पाया जा सकता है, जहां अंश नमूने के रूप में साधनों का इलाज करके गठित सहप्रसरण मैट्रिक्स है, और भाजक साझा सहप्रसरण मैट्रिक्स है। विवरण के लिए ऊपर "#Multiclass LDA" देखें।

अनुप्रयोग

नीचे दिए गए उदाहरणों के अलावा, एलडीए को स्थिति (विपणन) और उत्पाद प्रबंधन में लागू किया जाता है।

दिवालियापन की भविष्यवाणी

लेखा अनुपात और अन्य वित्तीय चर के आधार पर दिवालियापन की भविष्यवाणी में, रैखिक विभेदक विश्लेषण व्यवस्थित रूप से यह समझाने के लिए लागू किया गया पहला सांख्यिकीय तरीका था कि कौन सी फर्म दिवालिएपन में प्रवेश कर गई बनाम बच गई। एलडीए की सामान्य वितरण धारणाओं के लिए लेखा अनुपात के ज्ञात गैर-अनुरूपता सहित सीमाओं के बावजूद, एडवर्ड ऑल्टमैन का जेड-स्कोर वित्तीय विश्लेषण उपकरण अभी भी व्यावहारिक अनुप्रयोगों में एक अग्रणी मॉडल है।

चेहरे की पहचान

कम्प्यूटरीकृत चेहरे की पहचान प्रणाली में, प्रत्येक चेहरे को बड़ी संख्या में पिक्सेल मानों द्वारा दर्शाया जाता है। वर्गीकरण से पहले अधिक प्रबंधनीय संख्या में सुविधाओं की संख्या को कम करने के लिए रैखिक विभेदक विश्लेषण का मुख्य रूप से उपयोग किया जाता है। प्रत्येक नया आयाम पिक्सेल मानों का एक रैखिक संयोजन है, जो एक टेम्पलेट बनाता है। फिशर के रैखिक विवेचक का उपयोग करके प्राप्त रैखिक संयोजनों को फिशर चेहरे कहा जाता है, जबकि संबंधित प्रमुख घटक विश्लेषण का उपयोग करके प्राप्त किए गए संयोजनों को ईजेनफेस कहा जाता है।

मार्केटिंग

विपणन में, भेदभावपूर्ण विश्लेषण का उपयोग अक्सर उन कारकों को निर्धारित करने के लिए किया जाता था जो विभिन्न प्रकार के ग्राहकों और / या उत्पादों को सर्वेक्षण या अन्य प्रकार के एकत्रित डेटा के आधार पर अलग करते हैं। लॉजिस्टिक रिग्रेशन या अन्य तरीके अब अधिक सामान्य रूप से उपयोग किए जाते हैं। विपणन में विभेदक विश्लेषण के उपयोग को निम्नलिखित चरणों द्वारा वर्णित किया जा सकता है:

- समस्या तैयार करें और डेटा एकत्र करें- इस श्रेणी में उत्पादों का मूल्यांकन करने के लिए उपयोग किए जाने वाले सामाजिक गुणों की पहचान करें- मात्रात्मक विपणन अनुसंधान तकनीकों (जैसे सांख्यिकीय सर्वेक्षण) का उपयोग करें ताकि सभी उत्पाद विशेषताओं की रेटिंग के संबंध में संभावित ग्राहकों के नमूने से डेटा एकत्र किया जा सके . डेटा संग्रह चरण आमतौर पर विपणन अनुसंधान पेशेवरों द्वारा किया जाता है। सर्वेक्षण के प्रश्न प्रतिवादी को शोधकर्ता द्वारा चुनी गई विशेषताओं की एक श्रृंखला पर उत्पाद को एक से पांच (या 1 से 7, या 1 से 10) तक रेट करने के लिए कहते हैं। कहीं भी पाँच से बीस विशेषताओं का चयन किया जाता है। उनमें निम्न चीज़ें शामिल हो सकती हैं: उपयोग में आसानी, वजन, सटीकता, टिकाऊपन, रंगीनता, कीमत या आकार। चुने गए गुण अध्ययन किए जा रहे उत्पाद के आधार पर अलग-अलग होंगे। अध्ययन में सभी उत्पादों के बारे में एक ही प्रश्न पूछा गया है। कई उत्पादों के डेटा को संहिताबद्ध किया जाता है और एक सांख्यिकीय कार्यक्रम जैसे आर भाषा, एसपीएसएस या एसएएस प्रोग्रामिंग भाषा में इनपुट किया जाता है। (यह चरण कारक विश्लेषण के समान है)।

- डिस्क्रिमिनेंट फंक्शन गुणांक का अनुमान लगाएं और सांख्यिकीय महत्व और वैधता निर्धारित करें- उपयुक्त डिस्क्रिमिनेंट विश्लेषण विधि चुनें। प्रत्यक्ष विधि में विवेचक फलन का आकलन करना शामिल है ताकि सभी भविष्यवक्ताओं का एक साथ मूल्यांकन किया जा सके। स्टेप चरणबद्ध प्रतिगमन भविष्यवाणियों में क्रमिक रूप से प्रवेश करता है। दो-समूह विधि का उपयोग तब किया जाना चाहिए जब आश्रित चर में दो श्रेणियां या अवस्थाएँ हों। एकाधिक विभेदक विधि का उपयोग तब किया जाता है जब आश्रित चर में तीन या अधिक श्रेणीबद्ध अवस्थाएँ होती हैं। विल्क्स लैम्ब्डा डिस्ट्रीब्यूशन का प्रयोग करें। एसपीएसएस में महत्व या एसएएस में एफ स्टेट के परीक्षण के लिए विल्क्स लैम्ब्डा का उपयोग करें। वैधता का परीक्षण करने के लिए उपयोग की जाने वाली सबसे आम विधि नमूने को एक अनुमान या विश्लेषण नमूने और एक सत्यापन या होल्डआउट नमूने में विभाजित करना है। अनुमान नमूना का उपयोग विवेचक फलन के निर्माण में किया जाता है। सत्यापन नमूने का उपयोग एक वर्गीकरण मैट्रिक्स के निर्माण के लिए किया जाता है जिसमें सही ढंग से वर्गीकृत और गलत वर्गीकृत मामलों की संख्या शामिल होती है। सही ढंग से वर्गीकृत मामलों के प्रतिशत को हिट अनुपात कहा जाता है।

- परिणामों को दो आयामी मानचित्र पर प्लॉट करें, आयामों को परिभाषित करें और परिणामों की व्याख्या करें। सांख्यिकीय कार्यक्रम (या संबंधित मॉड्यूल) परिणामों को मैप करेगा। नक्शा प्रत्येक उत्पाद को प्लॉट करेगा (आमतौर पर द्वि-आयामी अंतरिक्ष में)। उत्पादों की एक-दूसरे से दूरी यह दर्शाती है कि वे कितने भिन्न हैं। आयामों को शोधकर्ता द्वारा लेबल किया जाना चाहिए। इसके लिए व्यक्तिपरक निर्णय की आवश्यकता होती है और यह अक्सर बहुत चुनौतीपूर्ण होता है। अवधारणात्मक मानचित्रण देखें।

बायोमेडिकल अध्ययन

चिकित्सा में विभेदक विश्लेषण का मुख्य अनुप्रयोग एक रोगी की गंभीरता की स्थिति का आकलन और रोग के परिणाम का पूर्वानुमान है। उदाहरण के लिए, पूर्वव्यापी विश्लेषण के दौरान, रोगियों को रोग की गंभीरता के अनुसार समूहों में विभाजित किया जाता है - हल्का, मध्यम और गंभीर रूप। फिर नैदानिक और प्रयोगशाला विश्लेषण के परिणामों का अध्ययन किया जाता है ताकि उन चरों को प्रकट किया जा सके जो अध्ययन किए गए समूहों में सांख्यिकीय रूप से भिन्न हैं। इन चरों का उपयोग करते हुए, विभेदक कार्यों का निर्माण किया जाता है जो भविष्य के रोगी में बीमारी को हल्के, मध्यम या गंभीर रूप में वर्गीकृत करने में मदद करते हैं।

जीव विज्ञान में, समान सिद्धांतों का उपयोग विभिन्न जैविक वस्तुओं के समूहों को वर्गीकृत करने और परिभाषित करने के लिए किया जाता है, उदाहरण के लिए, फूरियर ट्रांसफॉर्म इन्फ्रारेड स्पेक्ट्रा के आधार पर साल्मोनेला एंटरिटिडिस के फेज प्रकारों को परिभाषित करने के लिए,[25] एस्चेरिचिया कोलाई के पशु स्रोत का पता लगाने के लिए इसके विषाणु कारकों का अध्ययन करना[26] वगैरह।

पृथ्वी विज्ञान

इस तरीके का इस्तेमाल किया जा सकता है separate the alteration zones[clarification needed]. उदाहरण के लिए, जब विभिन्न क्षेत्रों से अलग-अलग डेटा उपलब्ध होते हैं, तो विवेकशील विश्लेषण डेटा के पैटर्न को ढूंढ सकता है और इसे प्रभावी ढंग से वर्गीकृत कर सकता है।[27]

रसद प्रतिगमन की तुलना

विभेदक कार्य विश्लेषण रसद प्रतिगमन के समान है, और दोनों का उपयोग समान शोध प्रश्नों के उत्तर देने के लिए किया जा सकता है।[9]तार्किक प्रतिगमन में विवेकपूर्ण विश्लेषण के रूप में कई धारणाएं और प्रतिबंध नहीं हैं। हालाँकि, जब डिस्क्रिमिनेंट एनालिसिस की धारणाएँ पूरी होती हैं, तो यह लॉजिस्टिक रिग्रेशन से अधिक शक्तिशाली होता है।[28] लॉजिस्टिक प्रतिगमन के विपरीत, विभेदक विश्लेषण का उपयोग छोटे नमूना आकारों के साथ किया जा सकता है। यह दिखाया गया है कि जब नमूना आकार समान होते हैं, और विचरण / सहप्रसरण की एकरूपता होती है, तो विवेचक विश्लेषण अधिक सटीक होता है।[7]इन सभी फायदों के बावजूद, लॉजिस्टिक रिग्रेशन कम से कम आम पसंद बन गया है, क्योंकि भेदभावपूर्ण विश्लेषण की धारणाएं शायद ही कभी पूरी होती हैं।[8][7]

उच्च आयाम में रैखिक विवेचक

उच्च आयामों में ज्यामितीय विसंगतियाँ आयामीता के प्रसिद्ध अभिशाप की ओर ले जाती हैं। फिर भी, माप परिघटना की सघनता का उचित उपयोग संगणना को आसान बना सकता है।[29] आयामीता के इन अभिशाप का एक महत्वपूर्ण मामला # आयामीता की घटना का आशीर्वाद डोनोहो और टान्नर द्वारा उजागर किया गया था: यदि एक नमूना अनिवार्य रूप से उच्च-आयामी है, तो प्रत्येक बिंदु को बाकी के नमूने से रैखिक असमानता से अलग किया जा सकता है, उच्च संभावना के साथ, यहां तक कि घातीय रूप से बड़े नमूने।[30] इन रैखिक असमानताओं को संभाव्यता वितरण के एक समृद्ध परिवार के लिए रैखिक विवेचक के मानक (फिशर) रूप में चुना जा सकता है।[31] विशेष रूप से, इस तरह के प्रमेय लॉगरिदमिक रूप से अवतल माप के लिए सिद्ध होते हैं। बहुभिन्नरूपी सामान्य वितरण सहित लॉग-अवतल वितरण (सबूत लॉग-अवतल उपायों के लिए एकाग्रता असमानताओं पर आधारित है)[32]) और एक बहुआयामी घन पर उत्पाद के उपायों के लिए (यह उत्पाद संभाव्यता रिक्त स्थान के लिए तालग्रैंड की एकाग्रता असमानता का उपयोग करके सिद्ध होता है)। शास्त्रीय रेखीय विभेदकों द्वारा डेटा पृथक्करण उच्च आयाम में कृत्रिम बुद्धिमत्ता प्रणालियों के लिए त्रुटि सुधार की समस्या को सरल करता है।[33]

यह भी देखें

- डेटा खनन

- निर्णय वृक्ष सीखना

- कारक विश्लेषण

- कर्नेल फिशर डिस्क्रिमिनेंट एनालिसिस

- लोगिट (लॉजिस्टिक रिग्रेशन के लिए)

- रेखीय प्रतिगमन

- एकाधिक विभेदक विश्लेषण

- बहुआयामी स्केलिंग

- पैटर्न मान्यता

- वरीयता प्रतिगमन

- द्विघात वर्गीकारक

- सांख्यिकीय वर्गीकरण

संदर्भ

- ↑ 1.0 1.1 Fisher, R. A. (1936). "टैक्सोनोमिक समस्याओं में एकाधिक मापन का उपयोग" (PDF). Annals of Eugenics. 7 (2): 179–188. doi:10.1111/j.1469-1809.1936.tb02137.x. hdl:2440/15227.

- ↑ McLachlan, G. J. (2004). विभेदक विश्लेषण और सांख्यिकीय पैटर्न पहचान. Wiley Interscience. ISBN 978-0-471-69115-0. MR 1190469.

- ↑ Analyzing Quantitative Data: An Introduction for Social Researchers, Debra Wetcher-Hendricks, p.288

- ↑ 4.0 4.1 Martinez, A. M.; Kak, A. C. (2001). "पीसीए बनाम एलडीए" (PDF). IEEE Transactions on Pattern Analysis and Machine Intelligence. 23 (2): 228–233. doi:10.1109/34.908974.

- ↑ Abdi, H. (2007) "Discriminant correspondence analysis." In: N.J. Salkind (Ed.): Encyclopedia of Measurement and Statistic. Thousand Oaks (CA): Sage. pp. 270–275.

- ↑ Perriere, G.; Thioulouse, J. (2003). "बैक्टीरियल प्रोटीन के उपकोशिकीय स्थान की भविष्यवाणी करने के लिए पत्राचार विभेदक विश्लेषण का उपयोग". Computer Methods and Programs in Biomedicine. 70 (2): 99–105. doi:10.1016/s0169-2607(02)00011-1. PMID 12507786.

- ↑ 7.0 7.1 7.2 7.3 7.4 7.5 7.6 7.7 7.8 7.9 Büyüköztürk, Ş. & Çokluk-Bökeoğlu, Ö. (2008). Discriminant function analysis: Concept and application. Egitim Arastirmalari - Eurasian Journal of Educational Research, 33, 73-92.

- ↑ 8.0 8.1 Cohen et al. Applied Multiple Regression/Correlation Analysis for the Behavioural Sciences 3rd ed. (2003). Taylor & Francis Group.

- ↑ 9.00 9.01 9.02 9.03 9.04 9.05 9.06 9.07 9.08 9.09 9.10 Green, S.B. Salkind, N. J. & Akey, T. M. (2008). Using SPSS for Windows and Macintosh: Analyzing and understanding data. New Jersey: Prentice Hall.

- ↑ Venables, W. N.; Ripley, B. D. (2002). एस के साथ आधुनिक एप्लाइड सांख्यिकी (4th ed.). Springer Verlag. ISBN 978-0-387-95457-8.

- ↑ Lachenbruch, P. A. (1975). Discriminant analysis. NY: Hafner

- ↑ Klecka, William R. (1980). Discriminant analysis. Quantitative Applications in the Social Sciences Series, No. 19. Thousand Oaks, CA: Sage Publications.

- ↑ Hardle, W., Simar, L. (2007). Applied Multivariate Statistical Analysis. Springer Berlin Heidelberg. pp. 289–303.

- ↑ Garson, G. D. (2008). Discriminant function analysis. https://web.archive.org/web/20080312065328/http://www2.chass.ncsu.edu/garson/pA765/discrim.htm.

- ↑ 15.0 15.1 15.2 Hardle, W., Simar, L. (2007). Applied Multivariate Statistical Analysis. Springer Berlin Heidelberg. pp. 289-303.

- ↑ Israel, Steven A. (June 2006). "Performance Metrics: How and When". Geocarto International. 21 (2): 23–32. doi:10.1080/10106040608542380. ISSN 1010-6049. S2CID 122376081.

- ↑ Garson, G. D. (2008). Discriminant function analysis. "PA 765: Discriminant Function Analysis". Archived from the original on 2008-03-12. Retrieved 2008-03-04. .

- ↑ Rao, R. C. (1948). "जैविक वर्गीकरण की समस्याओं में बहु मापन का उपयोग". Journal of the Royal Statistical Society, Series B. 10 (2): 159–203. JSTOR 2983775.

- ↑ 19.0 19.1 Aliyari Ghassabeh, Youness; Rudzicz, Frank; Moghaddam, Hamid Abrishami (2015-06-01). "तेजी से वृद्धिशील एलडीए सुविधा निष्कर्षण". Pattern Recognition. 48 (6): 1999–2012. Bibcode:2015PatRe..48.1999A. doi:10.1016/j.patcog.2014.12.012.

- ↑ Chatterjee, C.; Roychowdhury, V.P. (1997-05-01). "वर्ग-विभाजन सुविधाओं के लिए स्व-संगठित एल्गोरिदम और नेटवर्क पर". IEEE Transactions on Neural Networks. 8 (3): 663–678. doi:10.1109/72.572105. ISSN 1045-9227. PMID 18255669.

- ↑ Demir, G. K.; Ozmehmet, K. (2005-03-01). "रैखिक विभेदक विश्लेषण के लिए ऑनलाइन स्थानीय शिक्षण एल्गोरिदम". Pattern Recognit. Lett. 26 (4): 421–431. Bibcode:2005PaReL..26..421D. doi:10.1016/j.patrec.2004.08.005. ISSN 0167-8655.

- ↑ Yu, H.; Yang, J. (2001). "A direct LDA algorithm for high-dimensional data — with application to face recognition". Pattern Recognition. 34 (10): 2067–2069. Bibcode:2001PatRe..34.2067Y. CiteSeerX 10.1.1.70.3507. doi:10.1016/s0031-3203(00)00162-x.

- ↑ Friedman, J. H. (1989). "नियमित विभेदक विश्लेषण" (PDF). Journal of the American Statistical Association. 84 (405): 165–175. CiteSeerX 10.1.1.382.2682. doi:10.2307/2289860. JSTOR 2289860. MR 0999675.

- ↑ Ahdesmäki, M.; Strimmer, K. (2010). "कैट स्कोर और फाल्स नॉनडिस्कवरी रेट कंट्रोल का उपयोग करते हुए ओमिक्स भविष्यवाणी समस्याओं में फीचर चयन". Annals of Applied Statistics. 4 (1): 503–519. arXiv:0903.2003. doi:10.1214/09-aoas277. S2CID 2508935.

- ↑ Preisner, O; Guiomar, R; Machado, J; Menezes, JC; Lopes, JA (2010). "साल्मोनेला एंटरिका सेरोवर एंटरिटिडिस फेज प्रकारों के विभेदन के लिए फूरियर ट्रांसफॉर्म इंफ्रारेड स्पेक्ट्रोस्कोपी और केमोमेट्रिक्स का अनुप्रयोग". Appl Environ Microbiol. 76 (11): 3538–3544. Bibcode:2010ApEnM..76.3538P. doi:10.1128/aem.01589-09. PMC 2876429. PMID 20363777.

- ↑ David, DE; Lynne, AM; Han, J; Foley, SL (2010). "पशु चिकित्सा Escherichia कोलाई आइसोलेट्स के लक्षण वर्णन में विषाणु कारक प्रोफाइलिंग का मूल्यांकन". Appl Environ Microbiol. 76 (22): 7509–7513. Bibcode:2010ApEnM..76.7509D. doi:10.1128/aem.00726-10. PMC 2976202. PMID 20889790.

- ↑ Tahmasebi, P.; Hezarkhani, A.; Mortazavi, M. (2010). "Application of discriminant analysis for alteration separation; sungun copper deposit, East Azerbaijan, Iran. Australian" (PDF). Journal of Basic and Applied Sciences. 6 (4): 564–576.

- ↑ Trevor Hastie; Robert Tibshirani; Jerome Friedman. सांख्यिकीय सबक के तत्व। डेटा खनन, अनुमान और भविष्यवाणी (second ed.). Springer. p. 128.

- ↑ Kainen P.C. (1997) Utilizing geometric anomalies of high dimension: When complexity makes computation easier. In: Kárný M., Warwick K. (eds) Computer Intensive Methods in Control and Signal Processing: The Curse of Dimensionality, Springer, 1997, pp. 282–294.

- ↑ Donoho, D., Tanner, J. (2009) Observed universality of phase transitions in high-dimensional geometry, with implications for modern data analysis and signal processing, Phil. Trans. R. Soc. A 367, 4273–4293.

- ↑ Gorban, Alexander N.; Golubkov, Alexander; Grechuck, Bogdan; Mirkes, Evgeny M.; Tyukin, Ivan Y. (2018). "Correction of AI systems by linear discriminants: Probabilistic foundations". Information Sciences. 466: 303–322. arXiv:1811.05321. doi:10.1016/j.ins.2018.07.040. S2CID 52876539.

- ↑ Guédon, O., Milman, E. (2011) Interpolating thin-shell and sharp large-deviation estimates for isotropic log-concave measures, Geom. Funct. Anal. 21 (5), 1043–1068.

- ↑ Gorban, Alexander N.; Makarov, Valeri A.; Tyukin, Ivan Y. (July 2019). "उच्च-आयामी मस्तिष्क में छोटे तंत्रिका टुकड़ियों की अनुचित प्रभावशीलता". Physics of Life Reviews. 29: 55–88. arXiv:1809.07656. Bibcode:2019PhLRv..29...55G. doi:10.1016/j.plrev.2018.09.005. PMID 30366739.

अग्रिम पठन

- Duda, R. O.; Hart, P. E.; Stork, D. H. (2000). Pattern Classification (2nd ed.). Wiley Interscience. ISBN 978-0-471-05669-0. MR 1802993.

- Hilbe, J. M. (2009). Logistic Regression Models. Chapman & Hall/CRC Press. ISBN 978-1-4200-7575-5.

- Mika, S.; et al. (1999). "Fisher Discriminant Analysis with Kernels". Neural Networks for Signal Processing IX: Proceedings of the 1999 IEEE Signal Processing Society Workshop (Cat. No.98TH8468). pp. 41–48. CiteSeerX 10.1.1.35.9904. doi:10.1109/NNSP.1999.788121. ISBN 978-0-7803-5673-3. S2CID 8473401.

{{cite book}}:|journal=ignored (help) - McFarland, H. Richard; Donald, St. P. Richards (2001). "Exact Misclassification Probabilities for Plug-In Normal Quadratic Discriminant Functions. I. The Equal-Means Case". Journal of Multivariate Analysis. 77 (1): 21–53. doi:10.1006/jmva.2000.1924.

- McFarland, H. Richard; Donald, St. P. Richards (2002). "Exact Misclassification Probabilities for Plug-In Normal Quadratic Discriminant Functions. II. The Heterogeneous Case". Journal of Multivariate Analysis. 82 (2): 299–330. doi:10.1006/jmva.2001.2034.

- Haghighat, M.; Abdel-Mottaleb, M.; Alhalabi, W. (2016). "Discriminant Correlation Analysis: Real-Time Feature Level Fusion for Multimodal Biometric Recognition". IEEE Transactions on Information Forensics and Security. 11 (9): 1984–1996. doi:10.1109/TIFS.2016.2569061. S2CID 15624506.

बाहरी संबंध

- Discriminant Correlation Analysis (DCA) of the Haghighat article (see above)

- ALGLIB contains open-source LDA implementation in C# / C++ / Pascal / VBA.

- LDA in Python- LDA implementation in Python

- LDA tutorial using MS Excel

- Biomedical statistics. Discriminant analysis

- StatQuest: Linear Discriminant Analysis (LDA) clearly explained on YouTube

- Course notes, Discriminant function analysis by G. David Garson, NC State University

- Discriminant analysis tutorial in Microsoft Excel by Kardi Teknomo

- Course notes, Discriminant function analysis by David W. Stockburger, Missouri State University

- Discriminant function analysis (DA) by John Poulsen and Aaron French, San Francisco State University