न्यूनतम-कोण प्रतिगमन

This article may be too technical for most readers to understand. (April 2018) (Learn how and when to remove this template message) |

| एक श्रृंखला का हिस्सा |

| प्रतिगमन विश्लेषण |

|---|

| मॉडल |

| अनुमान |

| पार्श्वभूमि |

|

|

आंकड़ों में, न्यूनतम-कोण प्रतिगमन (एलएआरएस) उच्च-आयामी डेटा के लिए रैखिक प्रतिगमन मॉडल को फिट करने के लिए एक एल्गोरिदम है, जिसे ब्रैडली एफ्रॉन, ट्रेवर हेस्टी, इयान जॉनस्टोन (गणितज्ञ) और रॉबर्ट तिबशिरानी द्वारा विकसित किया गया है।[1]

मान लीजिए कि हम उम्मीद करते हैं कि एक प्रतिक्रिया चर संभावित सहसंयोजकों के सबसेट के रैखिक संयोजन द्वारा निर्धारित किया जाएगा। फिर LARS एल्गोरिदम अनुमान लगाने का एक साधन प्रदान करता है कि किन चरों को शामिल किया जाए, साथ ही उनके गुणांक भी।

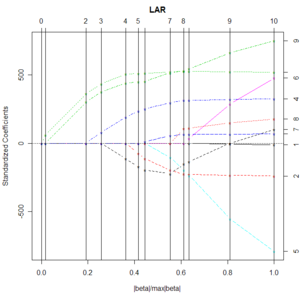

एक वेक्टर परिणाम देने के बजाय, LARS समाधान में पैरामीटर वेक्टर के L1 मानदंड के प्रत्येक मान के लिए समाधान को दर्शाने वाला एक वक्र होता है। एल्गोरिथ्म फॉरवर्ड स्टेप चरणबद्ध प्रतिगमन के समान है, लेकिन प्रत्येक चरण में चर को शामिल करने के बजाय, अनुमानित मापदंडों को अवशिष्ट के साथ प्रत्येक के सहसंबंध के समकोणीय दिशा में बढ़ाया जाता है।

फायदे और नुकसान

LARS पद्धति के लाभ हैं:

- यह कम्प्यूटेशनल रूप से फॉरवर्ड चयन जितना ही तेज़ है।

- यह एक पूर्ण टुकड़ा-वार रैखिक समाधान पथ तैयार करता है, जो क्रॉस-वैलिडेशन (सांख्यिकी) | क्रॉस-वैलिडेशन या मॉडल को ट्यून करने के समान प्रयासों में उपयोगी है।

- यदि दो चर प्रतिक्रिया के साथ लगभग समान रूप से सहसंबद्ध हैं, तो उनके गुणांक लगभग समान दर से बढ़ने चाहिए। इस प्रकार एल्गोरिथ्म अंतर्ज्ञान की अपेक्षा के अनुरूप व्यवहार करता है, और अधिक स्थिर भी है।

- समान परिणाम देने वाली अन्य विधियों, जैसे लैस्सो (सांख्यिकी) और फॉरवर्ड स्टेजवाइज रिग्रेशन के लिए कुशल एल्गोरिदम तैयार करने के लिए इसे आसानी से संशोधित किया जाता है।

- यह उन संदर्भों में प्रभावी है जहां पी ≫ एन (यानी, जब भविष्यवक्ताओं की संख्या पी अंक की संख्या से काफी अधिक है)[2]

LARS पद्धति के नुकसानों में शामिल हैं:

- आश्रित चर में किसी भी मात्रा में शोर और उच्च आयामी बहुसंरेखता स्वतंत्र चर के साथ, यह मानने का कोई कारण नहीं है कि चयनित चर में वास्तविक अंतर्निहित कारण चर होने की उच्च संभावना होगी। यह समस्या एलएआरएस के लिए अद्वितीय नहीं है, क्योंकि यह परिवर्तनीय चयन दृष्टिकोण के साथ एक सामान्य समस्या है जो अंतर्निहित नियतात्मक घटकों को ढूंढना चाहती है। फिर भी, क्योंकि एलएआरएस अवशेषों की पुनरावृत्तीय रीफिटिंग पर आधारित है, यह शोर के प्रभावों के प्रति विशेष रूप से संवेदनशील प्रतीत होता है। इस समस्या पर वीज़बर्ग द्वारा एफ्रॉन एट अल के चर्चा अनुभाग में विस्तार से चर्चा की गई है। (2004) एनल्स ऑफ स्टैटिस्टिक्स लेख।[3] वीज़बर्ग मूल रूप से एलएआरएस को मान्य करने के लिए उपयोग किए गए डेटा के पुन: विश्लेषण के आधार पर एक अनुभवजन्य उदाहरण प्रदान करता है कि चर चयन में अत्यधिक सहसंबद्ध चर के साथ समस्याएं प्रतीत होती हैं।

- चूंकि वास्तविक दुनिया में लगभग सभी उच्च आयामी डेटा संयोग से कम से कम कुछ चर में कुछ हद तक संरेखता प्रदर्शित करेंगे, LARS में सहसंबद्ध चर के साथ जो समस्या है, वह इसके अनुप्रयोग को उच्च आयामी डेटा तक सीमित कर सकती है।

एल्गोरिथम

न्यूनतम-कोण प्रतिगमन एल्गोरिथ्म के मूल चरण हैं:

- सभी गुणांकों से प्रारंभ करें शून्य के बराबर.

- भविष्यवक्ता खोजें के साथ सर्वाधिक सहसंबद्ध है .

- गुणांक बढ़ाएँ के साथ इसके सहसंबंध के संकेत की दिशा में . अवशेष ले लो जिस तरह से साथ। रुकें जब कोई अन्य भविष्यवक्ता के साथ उतना ही सहसंबंध है जैसा है।

- बढ़ोतरी (, ) उनके संयुक्त न्यूनतम वर्ग दिशा में, किसी अन्य भविष्यवक्ता तक अवशिष्ट के साथ उतना ही सहसम्बन्ध है .

- बढ़ोतरी (, , ) उनके संयुक्त न्यूनतम वर्ग दिशा में, किसी अन्य भविष्यवक्ता तक अवशिष्ट के साथ उतना ही सहसम्बन्ध है .

- तब तक जारी रखें जब तक: सभी भविष्यवक्ता मॉडल में न आ जाएं।[4]

सॉफ्टवेयर कार्यान्वयन

कम से कम कोण प्रतिगमन आर (भाषा) में lars पैकेज के माध्यम से, पायथन (भाषा) में [http:/ के साथ कार्यान्वित किया जाता है। /scikit-learn.org/stable/modules/linear_model.html#least-angel-regression scikit-learn] पैकेज, और एसएएस (सॉफ्टवेयर) में के माध्यम से /statug/63347/HTML/default/viewer.htm#statug_glmselect_a0000000242.htm GLMSELECT प्रक्रिया।

यह भी देखें

- उच्च-आयामी आँकड़े

- लैस्सो (सांख्यिकी)

- प्रतिगमन विश्लेषण

- मॉडल चयन

संदर्भ

- ↑ Efron, Bradley; Hastie, Trevor; Johnstone, Iain; Tibshirani, Robert (2004). "Least Angle Regression" (PDF). Annals of Statistics. 32 (2): pp. 407–499. arXiv:math/0406456. doi:10.1214/009053604000000067. MR 2060166. S2CID 204004121.

- ↑ Hastie, Trevor; Robert, Tibshirani; Jerome, Friedman (2009). The Elements of Statistical Learning Data Mining, Inference, and Prediction (2nd ed. 2009.) (PDF). Springer Series in Statistics. Springer New York. p. 76. doi:10.1007/978-0-387-84858-7. ISBN 978-0-387-84857-0.

- ↑ See Discussion by Weisberg following Efron, Bradley; Hastie, Trevor; Johnstone, Iain; Tibshirani, Robert (2004). "Least Angle Regression" (PDF). Annals of Statistics. 32 (2): pp. 407–499. arXiv:math/0406456. doi:10.1214/009053604000000067. MR 2060166. S2CID 204004121.

- ↑ "लैस्सो और न्यूनतम कोण प्रतिगमन की एक सरल व्याख्या". Archived from the original on 2015-06-21.